|

昨晚DeepSeek V3.1 Base / Instruct在 Hugging Face 上低调发布,但引起了巨大的社区反响。 🔑 更新亮点- 双版本发布:V3.1 Base(MIT开源许可)与 Instruct。

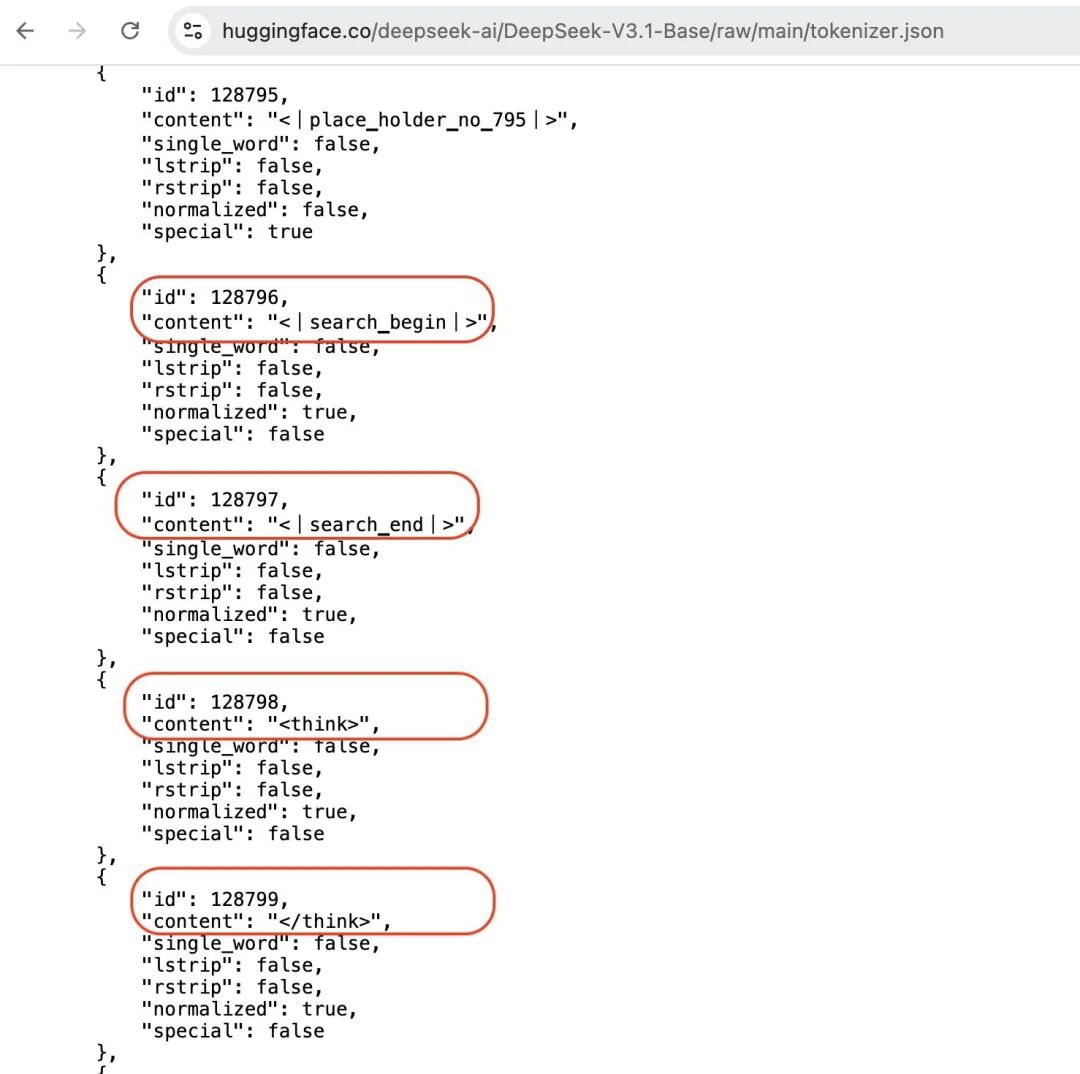

- 架构基本未改:与 V3 架构/配置差别不大,此次主要是后训练优化,并可能在尝试Anthropic 风格的 “no-think / think” 混合模式。

- MIT 开源许可:罕见的大体量基础模型采用宽松许可证,极具战略意义。

📊 参数规模- Hugging Face 卡片显示参数规模 >685B,是目前最大的开源模型之一,远超主流 LLaMA / Mistral 系列。

- 社区普遍认为这是对GPT-5等闭源模型的“对标性开源举措”。

🧪 早期评测- SVGBench:V3.1 Base(无思考模式)在代码评测中超过 V3.1 Thinking 与 R1-0528。

- Aider Polyglot Benchmark:据称在多语言代码基准上击败 Claude 4 Opus。

- 整体趋势:表现强于 V3,尤其是在编码与指令遵循方面。

💡 开发者社区观察- 行为特征:输出比 V3 更冗长、解释性更强,说明其指令对齐度和创造性提升明显。

- 混合架构推测:有人注意到 UI 里“think 按钮”消失,猜测已融合“思考模式”与普通模式。

- 应用场景:128k 上下文已确认上线,适合长文档、代码库分析。

🌍 影响与意义- 开源格局升级:MIT 许可 + 超大参数量 → 吸引学术与商业社区,可能成为未来 R2 系列的基座。

- 对标闭源巨头:性能据称已在部分编码任务超越 Claude 4 Opus,成为少数能与 GPT-5 级模型竞争的开源产品。

- 研究价值:Base 模型放出,便于复用、二次训练和基准对比,有助于探索后 Transformer 时代架构。

x上的一些网友评测@scaling01 DeepSeek V3.1 在 Aider Polyglot 基准上击败了 Claude 4 Opus,成为目前表现最强的非-TTC 编码模型,而其成本仅约 1 美元。 @swyx 看起来@deepseek_ai依旧稳步推进,DeepSeek V4很可能已经在路上了! 我这边整理了一下目前关于V3.1 Base的要点(毕竟现在没有一个地方能一次性看到所有信息): - 架构和 V3 基本一致,但进行了持续后训练,逐步演变为混合模型,同时引入了搜索与思考(search + think)能力。

- 在Aider Polyglot基准上击败 Claude 4 Opus。

可以预见,今年 11-12 月的模型大战会非常精彩。 |