ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">在开发AI应用时,一个精心调校的Prompt,即使昨天表现惊艳,今天面对新问题时也可能突然“智商掉线”。这种难以捉摸、时好时坏的状态,是所有AI应用开发者心中的痛。毕竟,在生产环境中,我们追求的是AI服务持续、可靠的稳定表现。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">字节最近在开源在这场大考中,有几个核心角色: - •评测集:这就是你的“考卷”。里面包含了一系列需要考察的题目(输入样本),你甚至可以为每道题附上标准答案(预期输出),用于后续评分。

- •评测对象:这就是那位“考生”。它可以是你写的一个

Prompt、一个扣子智能体,或是一个复杂的扣子工作流。 - •评估器:这就是那位目光如炬、铁面无私的“阅卷官”。它会依据你设定的评分标准,为“考生”的答卷逐一打分。

- •实验:这就是从“发卷”到“答题”,再到“批改”并最终生成详细“成绩单”的完整过程。

通过解读这份“成绩单”,我们能清晰地洞察AI的强项与弱点,从而进行有针对性的“补课”(调试优化),让它的能力日趋稳定与强大。 我们以“小红书爆款标题生成”这一真实场景为例,带你走完这场“AI期末考”的全流程。

第一环:精心命题,准备“考卷”(新建评测集)一场好的考试,始于一份高质量的试卷。我们需要创建一份包含各类典型场景的“考卷”。 首先,为考卷命名,例如“小红书标题写作能力测试卷”。

接着,开始录入考题。每一条数据,就是一道独立的题目。 接着,开始录入考题。每一条数据,就是一道独立的题目。

如果题目数量庞大,逐条录入效率太低。别担心,平台支持从本地文件批量导入,一键生成整份考卷。 如果题目数量庞大,逐条录入效率太低。别担心,平台支持从本地文件批量导入,一键生成整份考卷。

📌 关键一步:提交新版本 这个看似微小的“提交新版本”按钮,是决定后续能否顺利“开考”的核心。只有提交了版本,这份“考卷”才算正式“付印”,在后续创建实验时才能被系统找到。

第二环:聘请AI“阅卷官”(创建评估器)考卷就绪,接下来需要一位严格的“阅卷官”。 这正是“扣子罗盘”的精妙之处:这位“阅卷官”,本身也是一个由Prompt驱动的AI。换言之,我们正在用AI来评估AI。 我们需要为这位“AI阅卷官”提供一份详尽的“阅卷指南”(即提示词),清晰定义评分的标准与流程。 例如,下面是官方模板中的一位评判“指令遵从度”的阅卷官: title:"指令遵从度"评估器

你的任务是判断 AI 助手生成的回答是否严格遵循了系统或用户的提示指令。

<评判标准>

- 如果 AI 回答完整、准确地响应了提示指令的要求,且未偏离任务,则得 1 分。

- 如果 AI 回答部分遵循了指令,但存在遗漏或偏离部分要求,得 0 分。

- 如果 AI 回答完全忽略或违背了指令,则得 0 分。

</评判标准>

<输入>

[提示指令]:{{instruction}}

[AI 回答]:{{ai_response}}

</输入>

<思考指导>

请仔细阅读提示指令,准确理解用户或系统希望模型执行的操作内容。然后判断 AI 的回答是否严格遵循了这些指令,是否完全准确地完成了任务要求。

根据Prompt 中的评判标准一步步思考、分析,满足评判标准就是 1 分,否则就是 0 分。

</思考指导>

可以看到,这位AI阅卷官的输入是“考题”{{instruction}}和“考生回答”{{ai_response}},而它的输出格式高度规范:一个【0到1】

之间的分数,以及打分的理由。专业且有理有据。

下面这是我为“小红书爆款标题”场景,定制的一位更专业的“阅卷官”。 下面这是我为“小红书爆款标题”场景,定制的一位更专业的“阅卷官”。

以下是“小红书标题评审专家”的详细指令。我首先要求AI阅卷官必须先深度思考,再给出分数。它有三个输入参数:帖子的{{POST_CONTENT}},我们提供的参考爆款标题{{REFERENCE_TITLES}}(标准答案),和考生AI生成的{{CANDIDATE_TITLE}}(考生答案)。 你是一位资深的小红书爆款标题专家评估师。你的任务不是创作,而是根据用户提供的“参考标题”作为唯一的黄金标准,来评估一个“待评估标题”的质量。

你的评估过程必须严格遵循以下逻辑:

1. **深度分析参考标题**: 首先,仔细研究“参考标题”列表,在`<思考>`标签内提炼出它们的共同特征。这包括但不限于:

* **核心词/主题**: 它们都围绕哪些关键词展开?(例如:“省钱”、“变美”、“踩坑”)

* **句式结构**: 它们是陈述句、疑问句还是感叹句?是否有固定的模式(如“数字+方法”、“问题+解决方案”)?

* **情绪钩子**: 运用了哪些词语来吸引眼球、引发共鸣或好奇?(例如:“绝了”、“救命”、“后悔没早知道”)

* **目标人群**: 是否明确或暗示了目标读者?(例如:“学生党”、“打工人”、“新手妈妈”)

* **符号/格式**: Emoji、空格、特殊符号的使用风格是怎样的?

2. **对标评估待评估标题**: 接下来,在`<思考>`标签内,将“待评估标题”与你刚提炼出的特征标尺进行比较,判断它在多大程度上模仿了参考标题的风格和精髓。

3. **给出评分和原因**: 基于以上对比分析,给出一个最终评分和评价。

* **评分标准**: 0-1分

* **0.8-1分**: 高度符合。风格、关键词、结构和情绪钩子都与参考标题非常匹配,几乎可以以假乱真。

* **0.5-0.7分**: 基本符合。抓住了部分核心元素,但在语气、细节或“网感”上存在一定偏差。

* **0.1-0.4分**: 不太符合。与参考标题的风格和核心要素相去甚远,没有学到精髓。

* **原因**: 清晰地说明你打分的原因。必须具体指出“待评估标题”的优点(与参考标题相似之处)和缺点(与参考标题不同之处)。

下面是一个完整的评估示例,请严格按照此格式执行任务。

...(示例部分与原文相同,此处省略以保持简洁)...

现在,请根据以下内容开始你的评估。

<帖子内容>

{{POST_CONTENT}}

</帖子内容>

<参考标题>

{{REFERENCE_TITLES}}

</参考标题>

<待评估标题>

{{CANDIDATE_TITLE}}

</待评估标题>

第三环:让“考生”登场(创建提示词)有了“考卷”和“阅卷官”,我们的主角——“考生”也该就位了。在这里,我们的“考生”就是一个为生成小红书标题而设计的Prompt。

我们在提示词里预留一个 我们在提示词里预留一个{{POST_CONTENT}}的变量“空位”。这样,考试开始时,系统就能自动将“考卷”中的题目(帖子内容)逐一填入,让Prompt批量作答。

**📌 一个同样关键的提醒:请再次确认,你已点击右上角的“提交新版本”!**

与评测集一样,你的Prompt也必须提交版本,才能被成功“拉入考场”。这一步是确保“考生”能准时参加考试的基础。

关于“评测对象”的补充说明简单来说,“评测对象”回答了这样一个问题:“今天我们到底要对谁进行考试?” 目前,扣子罗盘支持三种“考生”类型: - •

Coze 工作流

你可以根据实际需求灵活选择。

最终环节:考试开始!(新建实验)万事俱备。现在,让我们把“考卷”、“考生”和“阅卷官”集合到“考场”中,正式启动实验。 第一步:布置考场为本次实验命名,如“第一轮小红书标题生成Prompt效果评估”。

第二步:填写考试说明 第三步:选用“考卷”在这里,选择我们刚才创建的评测集及其对应版本。如果此处版本选项为空,请回到第一环,检查评测集是否已“提交新版本”。

第四步:指定入场“考生”情况一:评测 Prompt (本文的示例)

选择Prompt作为评测对象后,你需要明确三件事:- •Prompt key: 要测试的具体Prompt。

- •版本: 测试该Prompt的哪个版本(因为Prompt会不断迭代)。

- •字段映射 (Field Mapping): 这是核心概念,本质是建立数据对接的桥梁。

系统已自动检测到我们的Prompt里有一个“空位”{{POST_CONTENT}}。

我们要做的,就是告诉系统:请把“考卷”(评测集)里名为 我们要做的,就是告诉系统:请把“考卷”(评测集)里名为POST_CONTENT的那一列数据,填入Prompt的这个“空位”。如此,数据通路便被打通。

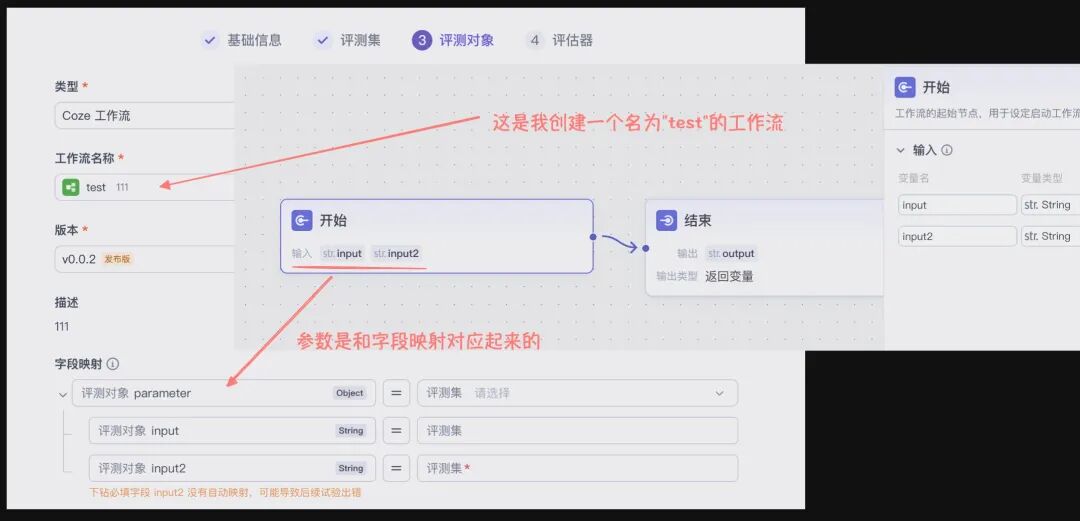

情况二:评测 Coze 工作流/智能体若评测对象是更复杂的Coze 工作流或智能体,流程也大同小异。例如,选择工作流后,系统会自动识别其输入参数。你要做的同样是“字段映射”——将“考卷”里的对应数据“喂”给这些参数。 Coze工作流评测    而智能体的核心输入通常是用户的提问input,映射关系更为直接。  实战展望:评测外部API对于使用LangChain或dify等框架自建AI应用的专业开发者而言,若能直接评测一个API接口,评估效率将极大提升,目前“扣子罗盘“不支持,需要进行二开。 Note 在真实的生产环境中,可以考虑对平台进行二次开发,增加“API”类型的评测对象。这样,只需传入API地址和认证信息,即可将任何外部AI服务无缝接入这个强大的评测体系。

第五步:指派“阅卷官”并分配任务最后一步,选择我们精心创建的“小红书标题评审”评估器。

此时,系统会自动解析出这位“阅卷官”需要三项输入:帖子内容、参考标题、待评估标题。  - •

{{POST_CONTENT}}→ 从评测集的input列获取。 - •

{{REFERENCE_TITLES}}→ 从评测集的reference_output列获取(标准答案)。 - •

{{CANDIDATE_TITLE}}→ 从上一步**评测对象(Prompt)**的输出结果中获取(考生答案)。

至此,一条清晰的数据流已经形成:考卷出题 → 考生答题 → 阅卷官拿着题目、考生答案和标准答案进行批改。 收官:解读“成绩单”,开启精准优化之旅!点击运行,稍作等待,一份详尽的“成绩单”便会生成。

这份报告,就是我们告别“玄学调优”的科学依据。它不仅是一个冰冷的分数,更是我们洞察AI模型能力、进行精准迭代的起点。 |