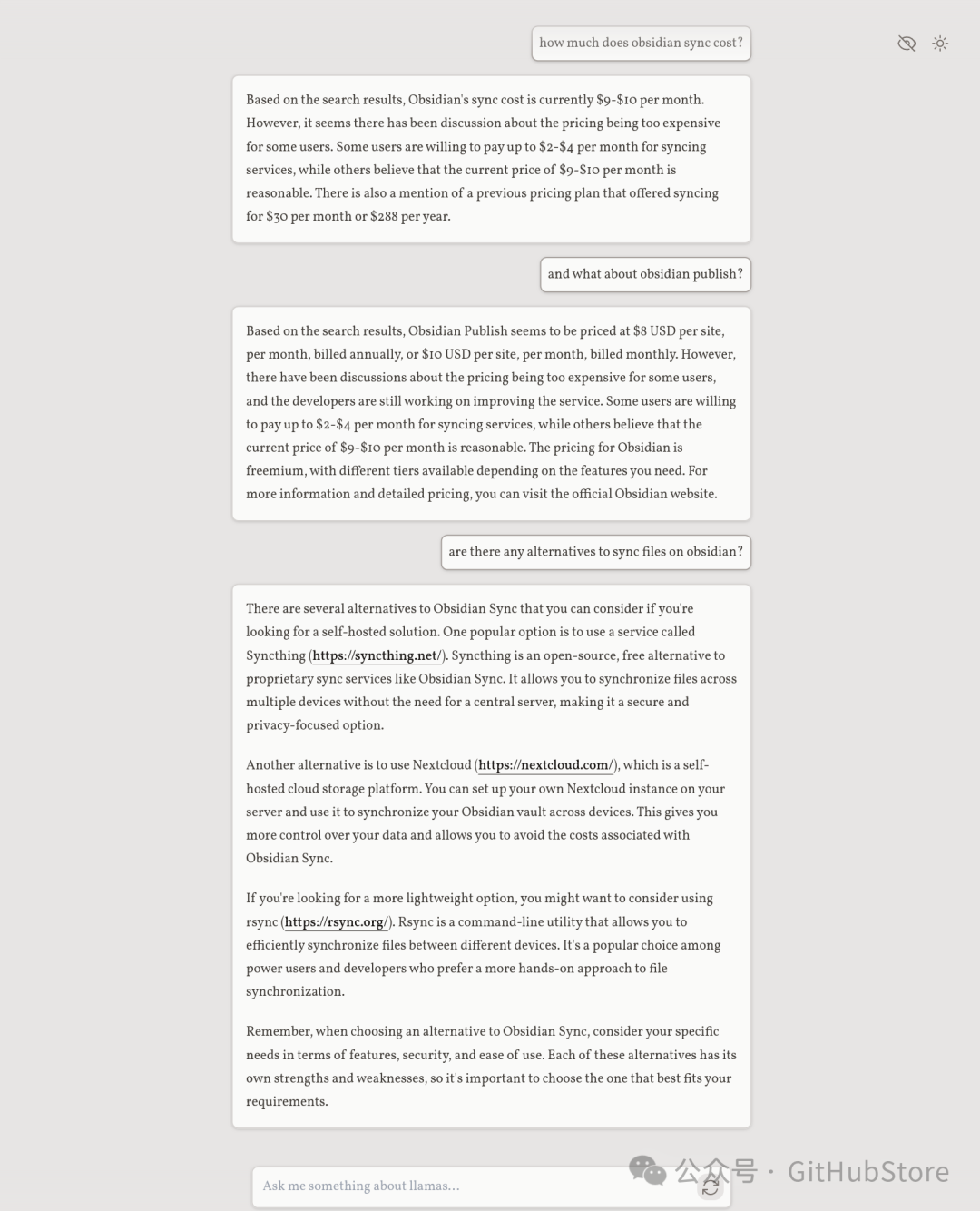

项目简介这是一个使用LLM代理的完全本地运行的元搜索引擎。用户可以提出一个问题,系统将使用一连串来LLMs找到答案。用户可以看到代理的进度和最终答案。不需要 OpenAI 或 Google API 密钥。

现在有后续问题:

地位这是一个概念证明,代码很可怕。我还不打算公开这个,但我想与一些人分享。如果您有任何建议,请打开问题和 PR。 特征

路线图

运作方式请阅读下文以获得最新的想法。

自托管/开发

目前,这两个选项是相同的。我计划将其打包到单个 docker 映像中,以便于部署。 要求网络中某处正在运行的 Ollama 服务器 LLocalSearch 使用hermes-2-pro-mistral模型进行测试,默认情况下会拉取此模型 将docker-compose.dev.yaml文件中OLLAMA_HOST的环境变量设置为 Ollama 服务器的 IP docker-compose.dev.yaml将文件中的环境OLLAMA_MODEL_NAME变量设置为要使用的模型名称

Docker Compose Make(可选)

撰写文件中包含的有

gitclonehttps://github.com/nilsherzig/LLocalsearch.git#makesuretochecktheenvvarsinsidethecomposefile#buildthecontainersandstarttheservicesmakedev#makedevwillstartthefrontendonport3000.Bothfrontandbackendwillhotreloadoncodechanges.#oruse"makerun"todetachthecontainers(anduse"makestop"tostopthem)#running"makeupgrade"willstopallcontainers,pullthelatestcodeandrestartthecontainers 如果您尚未 make 安装,则可以在 Makefile 中手动运行这些命令。 现在,您应该能够访问 http://localhost:3000 上的前端。所有其他服务均不向外界公开。

|