|

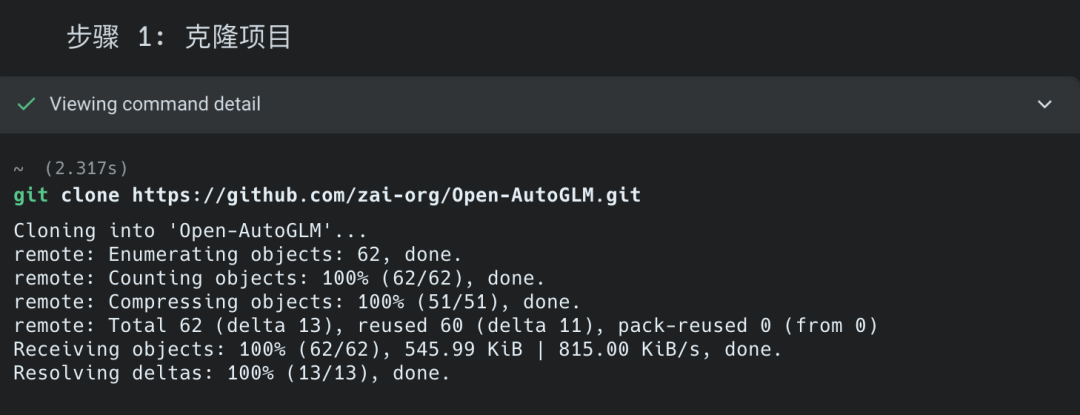

虽然开源,还是步骤还是蛮折腾的。 不太建议尝试,而且实现也很Low,就是用adb shell加的视觉模型。 目前AutoGLM最大的意义就是完成一个固定的流水线工作,说白了就是在之前截图取色上面进了一步而已。 你如果指望这些东西模拟和取代人类的操作,为时尚早。 我想说的暴论就是,手机Agent这种东西只有苹果或者Google系统x级别的厂商来做,其它的小厂最多就是隔靴搔痒。 以下全程使用Warp来完成,不需要你有任何的编辑基础,放文档就可以。 步骤 1:克隆项目

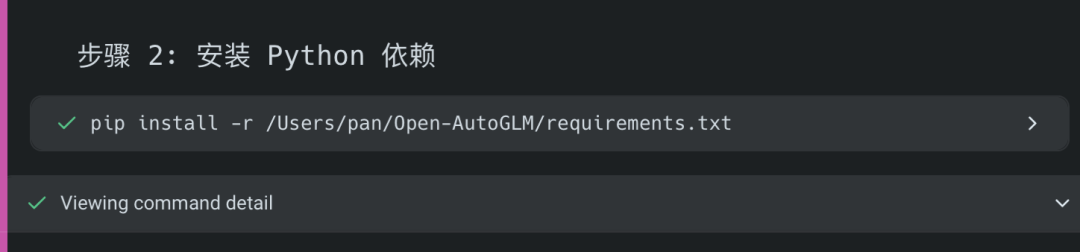

步骤 2:安装项目的依赖

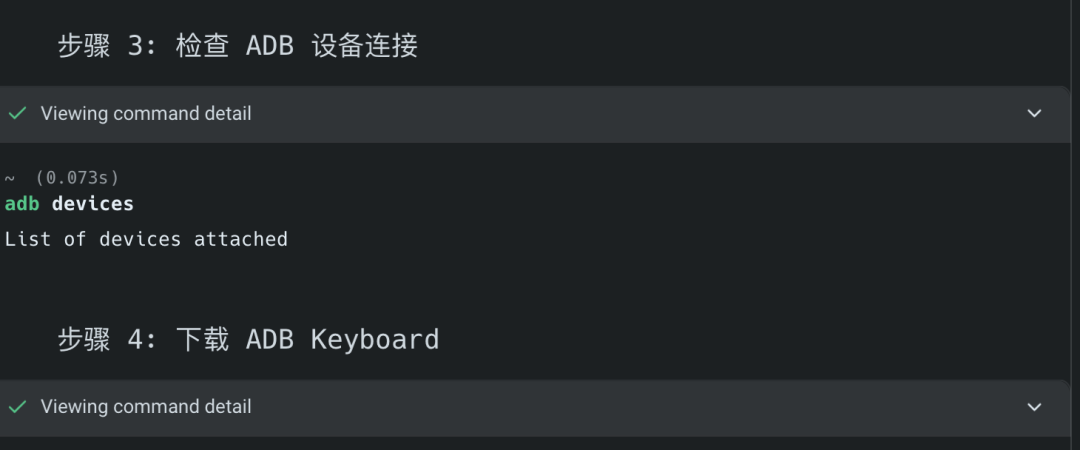

步骤 3:ADB相关的。 这个步骤是我提前就装好的,Warp估计可以,但是中间需要你的网络能正常上网。

接下来就是在手机上的操作了,每个手机界面不太一样。 大致如下: Android 设备配置 - 启用开发者模式

• 进入「设置 → 关于手机 → 版本号」

• 连续快速点击 10 次,直到提示"开发者模式已启用" - 启用 USB 调试

• 进入「设置 → 开发者选项 → USB 调试」

• 勾选启用

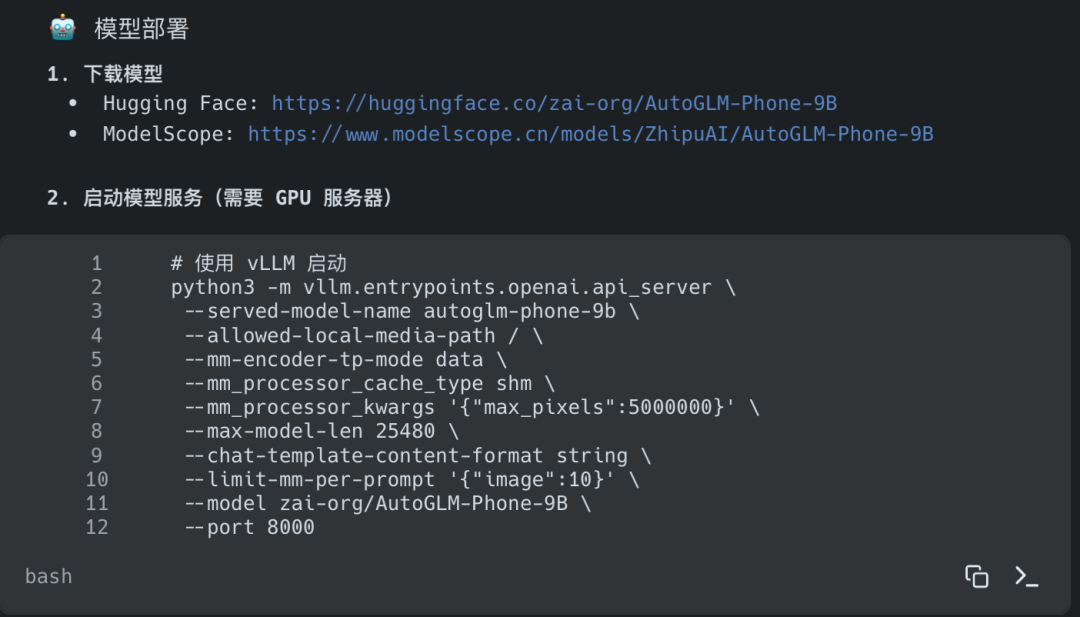

下一步是模型部署,需要 GPU 服务器

再就是安装一个代理软件 ADB Keyboard,主要是用它来实现虚拟键盘操作。 用数据线连接手机到电脑 #用数据线连接手机到电脑

adbdevices

#手机上会弹出授权提示,点击"允许" 安装 ADB Keyboard #连接设备后执行

cdOpen-AutoGLM

adbinstallADBKeyboard.apk

#然后在手机上:设置→系统→语言和输入法→虚拟键盘→启用ADBKeyboard 设备连接并启动模型服务后: cdOpen-AutoGLM

#查看支持的应用列表

pythonmain.py--list-apps

#执行任务(需要模型服务运行)

pythonmain.py--base-urlhttp://localhost:8000/v1--model"autoglm-phone-9b""打开美团搜索附近的火锅店" 然后就可以在手机上看到所谓的Agent自动操作手机了。 所以整套下来,AutoGLM虽然开源,但是对于普通用户来说,约等于没开源。 模型,手机,开发者模式,环境网络,座座都是大山。 另外屏幕捕获+OCR/视觉理解这条技术路线,本身就有很大的局限性。 它依赖截图,所以延迟高。 它不理解APP的内部逻辑,只能看到表面的像素。 它也无法处理需要系统级权限的操作。 它在APP禁止截图的页面上直接失效。 总而言之,这条路线可能只适合于简单的操作流,AutoGLM就是一个给开发者用的测试框架。 而未来的手机Agent有且只会是两家! |