准备模型

话不多说直接开始,模型下载地址:

https://modelscope.cn/models/XiaomiMiMo/MiMo-V2-Flash

https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

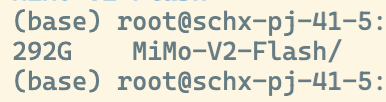

下载完成后,可以看到整个模型文件大小为292G

在众多知名的开源模型中,Mimo-V2-Flash与通义千问3-235B-FP8模型大小比较接近

简单做个对比如下

Mimo-V2-Flash是在FP8上原生训练的,然而Qwen3不是,所以这里仅对比同在FP8下的模型大小

部署准备

这里我的测试机器是一台8 * H100 80G的服务器

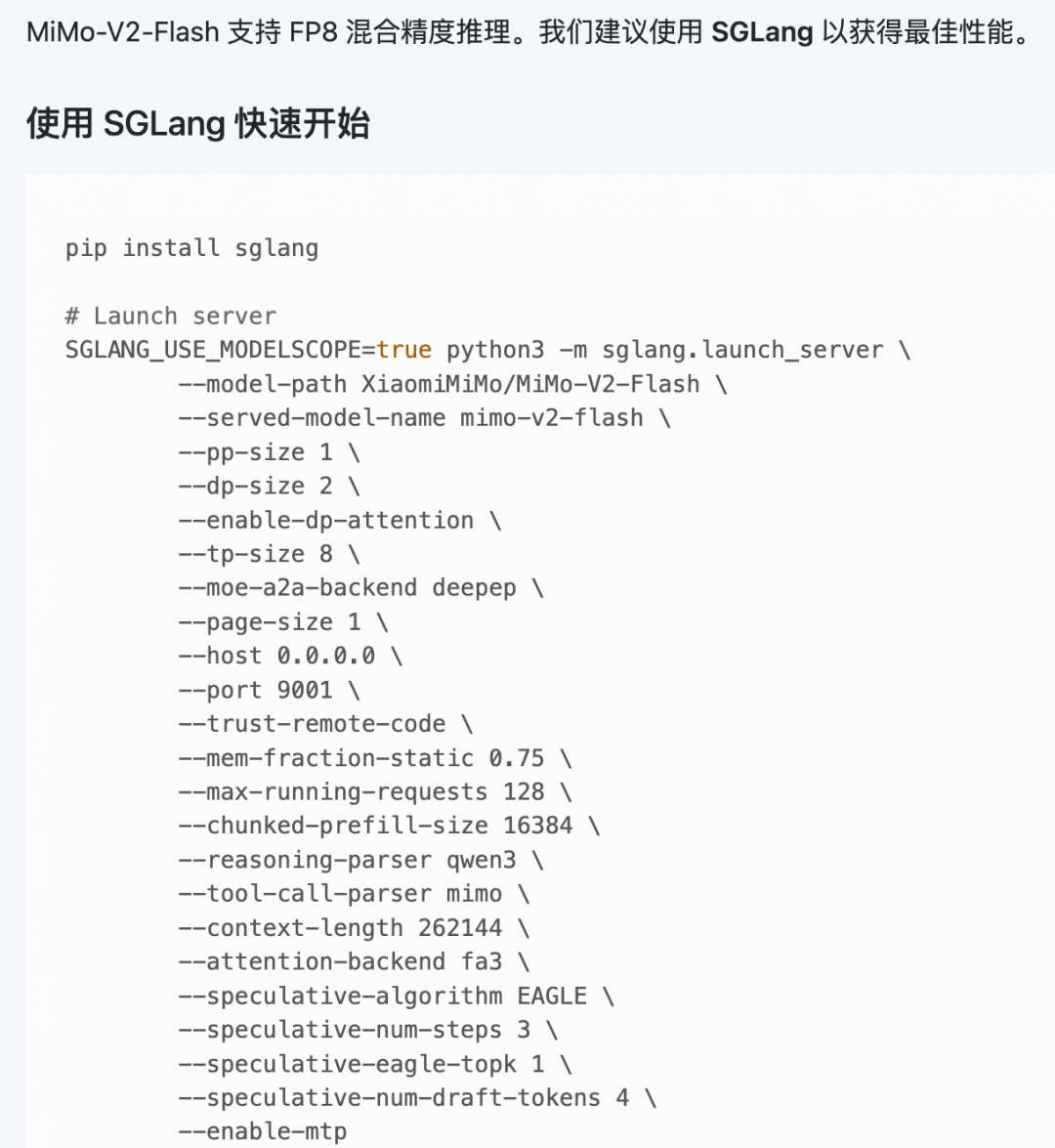

根据模型卡片描述,我们可以直接使用sglang的python包进行启动。

根据模型卡片描述,我们可以直接使用sglang的python包进行启动。

为了环境更纯净,通常来说用docker可能更简单点

我们可以找到sglang最近的dev版本

dockerpulllmsysorg/sglang:dev

截止到写稿时,sglang还没有发布正式支持Mimo-V2-Flash的新发布版本

小米牌面不行啊

,DeepSeek每次都是秒发

,DeepSeek每次都是秒发

部署开始

1.使用下面的启动命令,将容器挂起

docker run -d --gpus all \

--shm-size=32g \

--ipc=host \

--network=host \

--name mimo-v2 \

-v /path/to/huggingface:/root/.cache/huggingface \

lmsysorg/sglang:dev \

bash -c "while true; do sleep 3600; done"

2.进入容器

dockerexec-itmimo-v2bash

3.卸载容器内已经安装好的sglang,并安装包含了mimo-v2-flash的sglang

pip uninstall sglang -y

pip install sglang==0.5.6.post2.dev8005+pr.15207.g39d5bd57a \

--index-url https://sgl-project.github.io/whl/pr/ \

--extra-index-url https://pypi.org/simple

4.执行下面的命令来启动模型

export SGLANG_ENABLE_SPEC_V2=1

nohup python3 -m sglang.launch_server \

--model-path /root/.cache/huggingface/hub/XiaomiMiMo/MiMo-V2-Flash \

--served-model-name mimo-v2-flash \

--pp-size 1 \

--dp-size 2 \

--enable-dp-attention \

--tp-size 8 \

--moe-a2a-backend deepep \

--page-size 1 \

--trust-remote-code \

--tool-call-parser mimo \

--chunked-prefill-size 16384 \

--reasoning-parser qwen3 \

--context-length 262144 \

--attention-backend fa3 \

--speculative-algorithm EAGLE \

--speculative-num-steps 3 \

--speculative-eagle-topk 1 \

--speculative-num-draft-tokens 4 \

--host 0.0.0.0 \

--port 8000 > app.log 2>&1 &

需要注意的是,官网放出的--enable-mtp参数,在H100上无法正常启动,待后续引擎修复

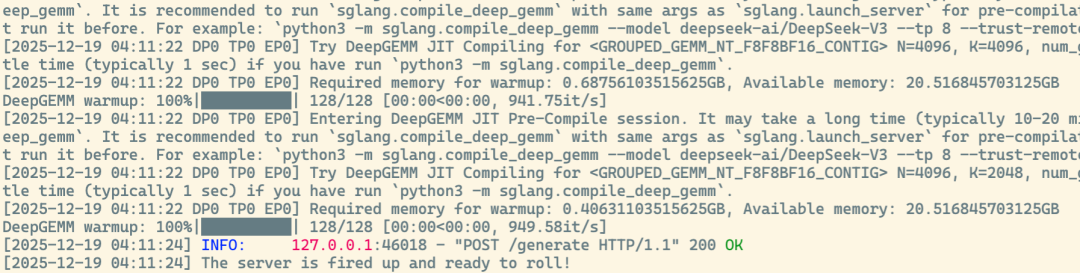

最后我们如果看到下面的日志,就表明启动成功啦!

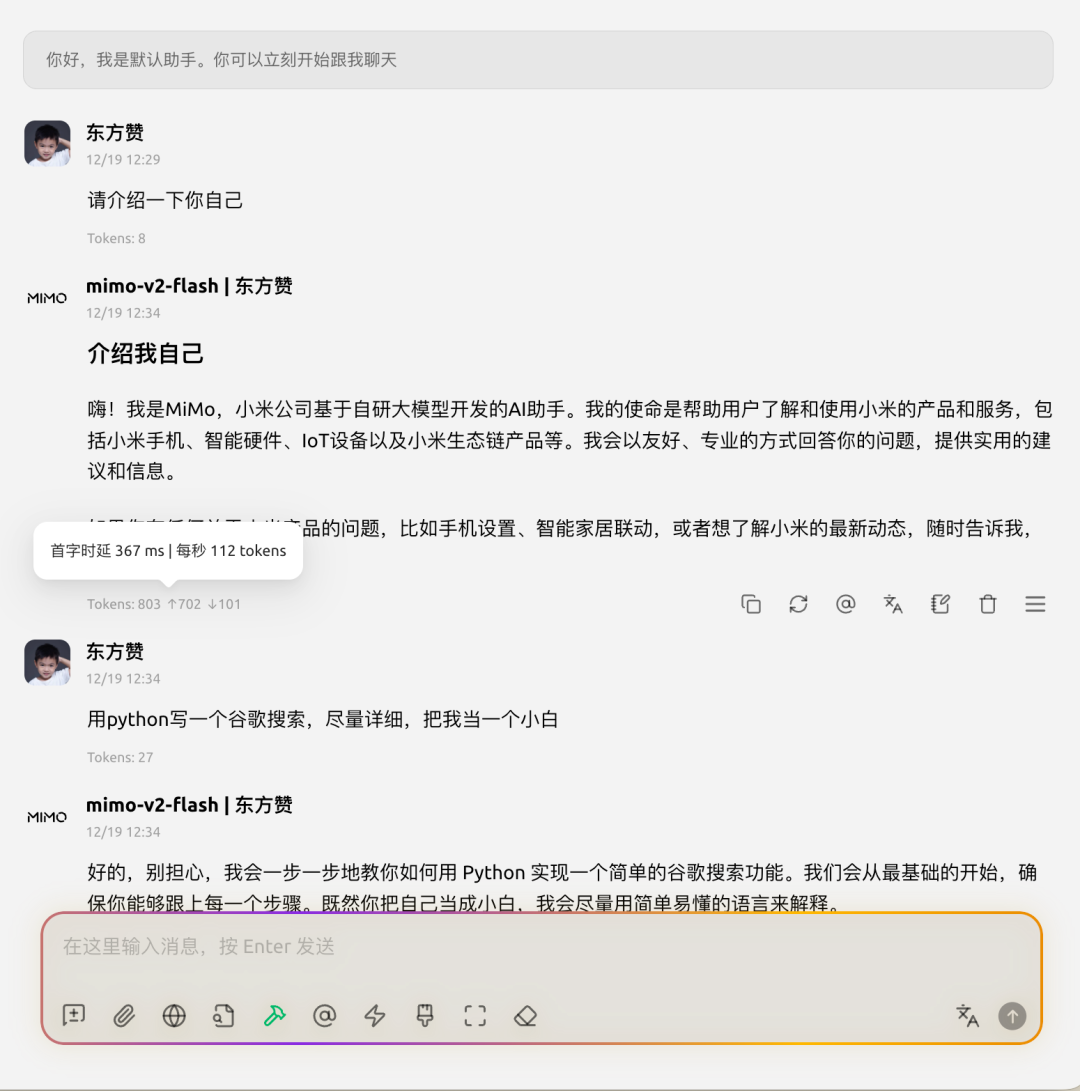

找一个AI客户端来看使用成果

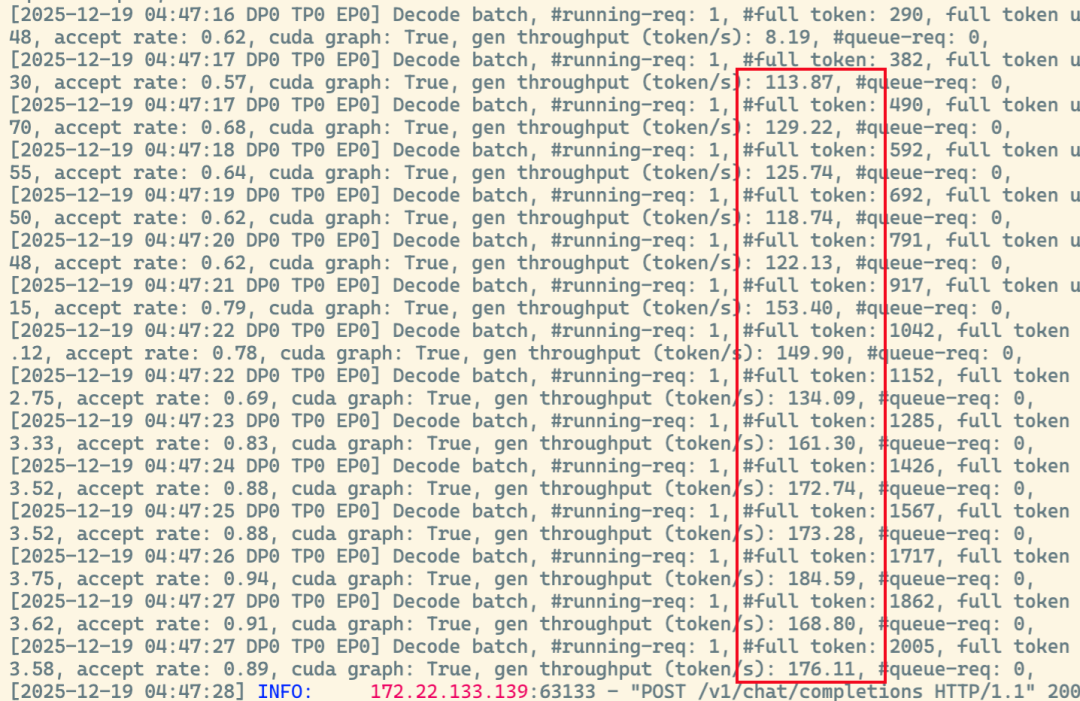

可以看到Decode的速度是非常快的

最快可以达到170tokens/s

平均也达到了110tokens/s,比较惊喜,超过了在默认启动参数下Qwen3-235B

深度思考

Mimo-V2-Flash是一个支持切换思考和非思考的模型

通过模型卡片描述的接口调用参数明细中得知

curl -i http://localhost:9001/v1/chat/completions \

-H 'Content-Type:application/json' \

-d '{

"messages" : [{

"role": "user",

"content": "Nice to meet you MiMo"

}],

"model": "mimo-v2-flash",

"max_tokens": 4096,

"temperature": 0.8,

"top_p": 0.95,

"stream": true,

"chat_template_kwargs": {

"enable_thinking": true

}

}'

Mimo-V2-Flash可以通过下面的参数来控制思考开关

"chat_template_kwargs": {

"enable_thinking": true

}

值得注意的是,与其他模型不同,在现阶段本地部署的Mimo-V2-Flash,enable_thinking是必须要传的

否则会导致模型回复的内容直接解析到了思考内容中,如下图所示

这可能是由于目前处在早期版本,sglang使用的通义千问的reasoning-parser导致的问题,待后续修复

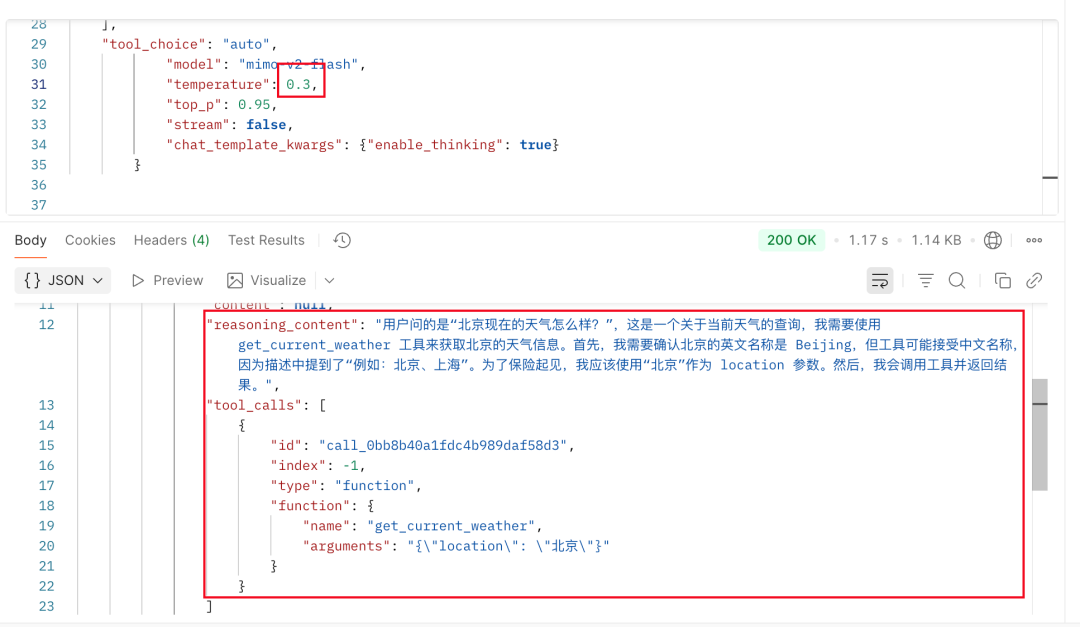

工具调用

在不开启深度思考模式时,目前工具调用可以正常使用

开启深度思考后,如果temperature过高,很大程度上会导致工具调用失败

开启深度思考后,如果temperature过高,很大程度上会导致工具调用失败

在使用官方推荐的temperature=0.3时,成功率较高

在使用官方推荐的temperature=0.3时,成功率较高

所以在使用时尽量按照官方文档中推荐的采样参数进行设置

IMPORTANT

推荐的采样参数:

top_p=0.95

temperature=0.8适用于数学、写作、Web 开发

temperature=0.3适用于自主任务(例如,氛围编码、工具使用)

结尾

好啦,这就是Mimo-V2-Flash在Day0的一些本地部署测试

目前还存在一些小bug,应该会在后续版本中修复,随着持续优化也会有更强的性能

接下来一段时间我这边也会持续使用一段时间这个模型

看一下在写作、编程等实际使用场景的效果如何

感谢你看到这里啦!