新手做 Agent,80% 时间搭建,20% 时间分析问题,老手正好反过来。

我最近看了吴恩达的 Agentic AI 课程,这是他的观察。

新手往往会踩一种坑:

花两周搭完系统,联调时发现第一步就错了,后面所有模块,都建在错误的地基上。

推倒重来。

以前我就是这么干的:拿到需求 → 脑子里过一遍思路 → 各模块逐个做完 → 最后串起来测试。

出现的问题是:你要到最后一步才知道前面哪里错了。

更惨的是,等你改完第一步,第二步的假设可能也不对了,又要改,改完第二步,第三步又崩了……

吴恩达给出的方法论正好相反:做一步,测一步,确认对了再往下走。

具体怎么做?下面用一个例子说明。

人类怎么做,AI 就怎么做

这是吴恩达特别强调的第一步,也是最反常识的一步:

大多数人拿到需求就开始思考「用什么模型」「怎么写 Prompt」「要不要用 RAG」,但吴恩达建议:

先找 5-10 个真实案例,自己当人类把这件事做一遍,记下每一步在想什么、查了什么、怎么决策的。

为什么要这么做?因为很多开发者连自己都没想清楚流程,就急着让 AI 去做。

举个例子,如果让你处理一封客服邮件,你怎么判断要不要查订单数据?看邮件里有没有订单号?还是根据发件人邮箱去猜?

没提供订单号时,你是直接回复「请提供订单号」,还是先根据用户名搜一下?

这些细节,如果你自己都没想清楚,AI 肯定也做不好。

所以阶段零的价值是:逼着你把流程梳理清楚,同时这些真实案例直接变成你后面的测评集。

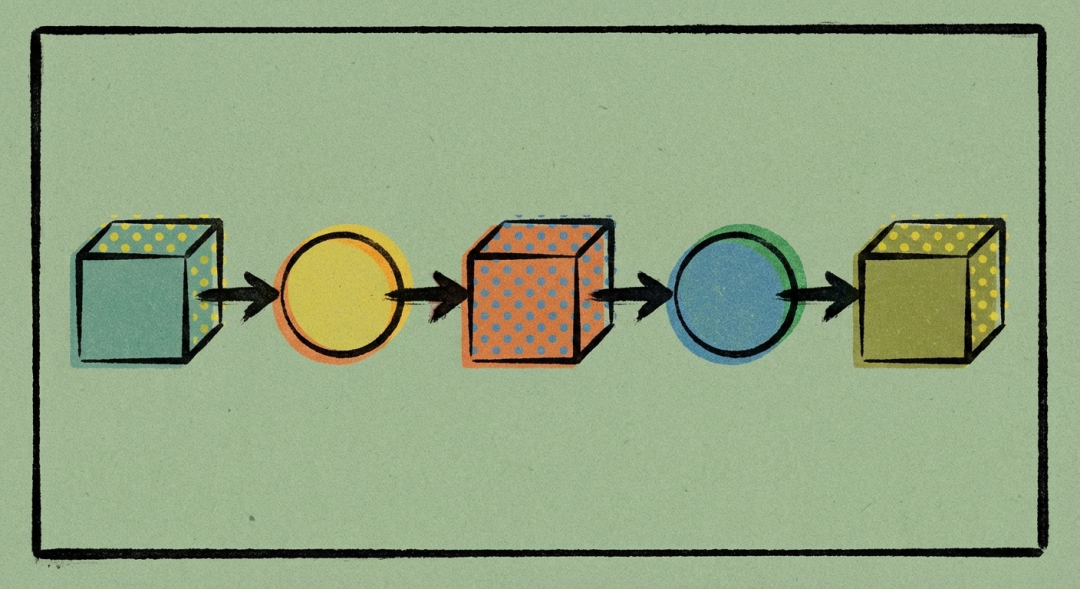

把人类流程翻译成 AI 流程

梳理完人类怎么做,接下来就把它翻译成 AI 能做的:

我的做法是把 Agent 拆成三部分:大脑(LLM)、手(工具)、眼(多模态)。

大脑:负责思考、决策、生成文本。

手:负责调用外部工具,执行具体任务。

眼:负责理解和处理多模态输入(如图片、视频)。

以客服邮件 Agent 为例:

第一步:打开邮件

- • AI:用邮件 API 读取邮箱号、标题、发件时间、正文(不可能真让 AI 去点鼠标,只能通过 API 获取数据)

第二步:判断要不要查订单

- • AI:用 LLM + Prompt,让它扮演客服角色,按什么原则去判断

第三步:查订单数据

- • 人类:打开数据库,输入订单号或用户名,看有没有匹配的

- • AI:提供数据库查询工具(API),LLM 决定查什么、怎么查

第四步:匹配验证

- • AI:让 LLM 对比邮件信息和订单信息,判断是不是同一个人

第五步:组织回复

- • AI:给 LLM 一个回复模板或原则,生成邮件内容

整个流程梳理完,你会发现:哪些步骤需要 LLM 思考,哪些步骤需要工具支持,哪些步骤能提前优化。

一目了然。

单点验证,而不是整体开发

流程翻译完,别急着搭整个系统。吴恩达的建议是:先单点验证,做一个测一个。

什么叫单点验证?比如邮件 API 能调通吗?有没有官方 API?没有的话第三方能不能实现?

LLM 判断「要不要查订单」这个任务,写个 Prompt 在 ChatGPT 里测几轮,能做到吗?

数据库查询工具,LLM 能正确调用吗?参数传递有没有问题?

这个阶段的重点是「能不能跑通」,而不是「质量如何」。

如果某个工具根本调不通,或者 LLM 完全理解不了你的意图,那就要重新考虑方案。

别等到整个系统搭完了才发现「这条路走不通」。

等每个单点都验证通过,再用工作流编排工具(比如 n8n、dify)或者自己写代码把它们串起来,确保数据流转正常。

这个阶段可能只需要 2-3 天,就能拿到一个能跑的原型。

测评集从小到大,循环优化

原型跑通之后,就进入评估阶段。

评估阶段第一件事:建测评集,但别一开始就建 100 个,10-20 个就够了。

为什么?因为 10-20 个足以发现大部分问题,标注成本低(你要写标准答案),迭代速度也快。

怎么做?

第一轮:肉眼看几个输出

随便跑几个案例,看看输出长什么样。这一步能快速发现明显问题,比如「完全没理解邮件内容」「查了订单但没用上」。

第二轮:建 10 个测试样本

从阶段零的真实案例里选 10 个,写好标准答案,跑一遍看准确率。

假设准确率只有 40%,别慌,这是正常的。

第三轮:错误分析

把失败的案例拎出来,逐个组件检查中间数据:是邮件理解错了?是数据库查询失败了?还是回复逻辑有问题?

统计一下:哪个环节错得最多?

假设发现「判断要不要查订单」这一步错误率 50%,那就优先优化这个组件。

第四轮:组件级优化

单独拎出这个组件,改 Prompt、加 Few-shot、换模型,测到满意为止。

比如原来准确率 10%,优化后提升到 60%。

第五轮:端到端重新测

组件优化完,回到完整流程重新跑一遍评估。

准确率从 40% → 65%。还不够?回到第三轮继续分析。

这是一个循环:评估 → 错误分析 → 优化组件 → 重新评估 → 再分析 → 再优化……

可能要转 3-5 轮,直到准确率达到你的目标。

什么时候可以停下来?

有个陷阱要注意:永远在优化,永远觉得「还不够好」。

怎么办?设个「Good Enough」的阶段性目标。

比如:

- • MVP 目标:端到端准确率 > 70%(可以内测)

- • 上线目标:端到端准确率 > 85%(可以小范围上线)

- • 成熟目标:端到端准确率 > 95%(全量推广)

为什么要设阈值?这样可以避免陷入完美主义,让你能阶段性交付。

先上线一个「能用」的版本,再根据真实反馈慢慢改。

而且有个现象:

好问题:用户太多,成本扛不住。

坏问题:又快又便宜,但质量差没人用。

所以质量优先,成本和速度是质量稳定之后才考虑的事。

整个方法论可以总结为:

阶段零:人工模拟 5-10 个真实案例,梳理清楚流程

阶段一:把人类流程翻译成 AI 流程(大脑-手-眼)

阶段二:单点验证,做一个测一个,串起来测数据流转

阶段三:建测评集(10个 → 20个 → 50个),循环优化(评估 → 分析 → 改进 → 再评估)

阶段四:设定 Good Enough 目标,质量稳定后再优化成本和速度

核心就是:分步验证、快速迭代、数据说话。

如果你在做 Agent,这套流程能帮你少走弯路。

更重要的是,它让你随时知道问题在哪,而不是凭感觉瞎改。