|

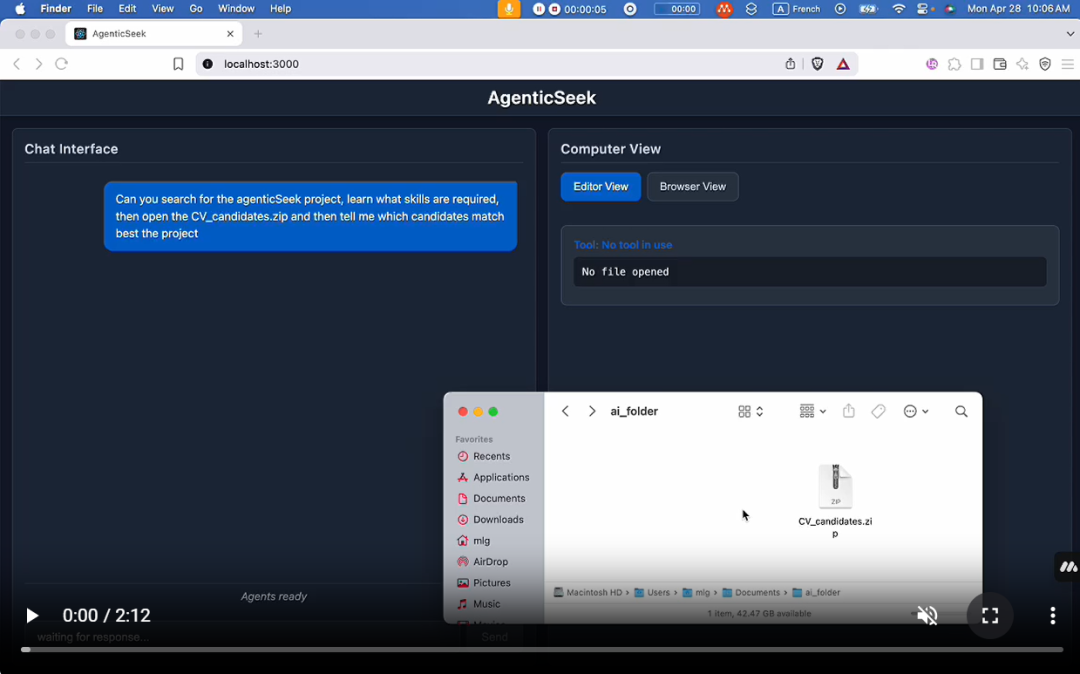

一个 100% 本地替代ManusAI 的方案,这款支持语音的 AI 助理能够自主浏览网页、编写代码和规划任务,同时将所有数据保留在您的设备上。专为本地推理模型量身打造,完全在您自己的硬件上运行,确保完全的隐私保护和零云端依赖。

主要功能? 完全本地化与隐私保护 - 所有功能都在您的设备上运行 — 无云端服务,无数据共享。您的文件、对话和搜索始终保持私密。 ? 智能网页浏览 - AgenticSeek 能够自主浏览互联网 — 搜索、阅读、提取信息、填写网页表单 — 全程无需人工操作。 ? 自主编码助手 - 需要代码?它可以编写、调试并运行 Python、C、Go、Java 等多种语言的程序 — 全程无需监督。 ? 智能代理选择 - 您提问,它会自动选择最适合该任务的代理。就像拥有一个随时待命的专家团队。 ? 规划与执行复杂任务 - 从旅行规划到复杂项目 — 它能将大型任务分解为步骤,并利用多个 AI 代理完成工作。 ?️ 语音功能 - 清晰、快速、未来感十足的语音与语音转文本功能,让您能像科幻电影中一样与您的个人 AI 助手对话。

安装确保已安装了 Chrome driver,Docker 和 Python 3.10(或更新)。 我们强烈建议您使用 Python 3.10 进行设置,否则可能会发生依赖错误。 有关于 Chrome driver 的问题,请参见 Chromedriver 部分。 1️⃣ 复制储存库与设置环境变数git clone https://github.com/Fosowl/agenticSeek.git

cd agenticSeek

mv .env.example .env

2️ 建立虚拟环境python3 -m venv agentic_seek_env

source agentic_seek_env/bin/activate

#On Windows: agentic_seek_env\Scripts\activate

3️⃣ 安装所需套件自动安装: ./install.sh

** 若要让文本转语音(TTS)功能支持中文,你需要安装 jieba(中文分词库)和 cn2an(中文数字转换库):** pip3 install jieba cn2an

手动安装: 注意:对于任何操作系统,请确保您安装的 ChromeDriver 与您已安装的 Chrome 版本匹配。运行google-chrome --version。如果您的 Chrome 版本 > 135,请参阅已知问题 更新软件包列表:sudo apt update 安装依赖项:sudo apt install -y alsa-utils portaudio19-dev python3-pyaudio libgtk-3-dev libnotify-dev libgconf-2-4 libnss3 libxss1 安装与您的 Chrome 浏览器版本匹配的 ChromeDriver:sudo apt install -y chromium-chromedriver 安装 requirements:pip3 install -r requirements.txt 更新 brew:brew update 安装 chromedriver:brew install --cask chromedriver 安装 portaudio:brew install portaudio 升级 pip:python3 -m pip install --upgrade pip 升级 wheel:pip3 install --upgrade setuptools wheel 安装 requirements:pip3 install -r requirements.txt 安装 pyreadline3:pip install pyreadline3 手动安装 portaudio(例如,通过 vcpkg 或预编译的二进制文件),然后运行:pip install pyaudio 从以下网址手动下载并安装 chromedriver:https://sites.google.com/chromium.org/driver/getting-started 将 chromedriver 放置在包含在您的 PATH 中的目录中。 安装 requirements:pip3 install -r requirements.txt 在本地机器上运行 AgenticSeek建议至少使用DeepSeek14B 以上参数的模型,较小的模型难以使用助理功能并且很快就会忘记上下文之间的关系。 本地运行助手 启动你的本地提供者,例如使用Ollama: ollama serve

请参阅下方支持的本地提供者列表。 更新 config.ini 修改 config.ini 文件以设置 provider_name 为支持的提供者,并将 provider_model 设置为该提供者支持的 LLM。我们推荐使用具有推理能力的模型,如 *Qwen* 或 *Deepseek*。 请参见 README 末尾的 FAQ 部分了解所需硬件。 [MAIN]

is_local = True # 无论是在本地运行还是使用远程提供者。

provider_name = ollama # 或 lm-studio, openai 等..

provider_model = deepseek-r1:14b # 选择适合您硬件的模型

provider_server_address = 127.0.0.1:11434

agent_name = Jarvis # 您的 AI 助手的名称

recover_last_session = True # 是否恢复之前的会话

save_session = True # 是否记住当前会话

speak = True # 文本转语音

listen = False # 语音转文本,仅适用于命令行界面

work_dir = /Users/mlg/Documents/workspace # AgenticSeek 的工作空间。

jarvis_personality = False # 是否使用更"贾维斯"风格的性格,不推荐在小型模型上使用

languages = en zh # 语言列表,文本转语音将默认使用列表中的第一种语言

[BROWSER]

headless_browser = True # 是否使用无头浏览器,只有在使用网页界面时才推荐使用。

stealth_mode = True # 使用无法检测的 selenium 来减少浏览器检测

警告:使用 LM-studio 运行 LLM 时,请*不要*将 provider_name 设置为openai。请将其设置为lm-studio。 注意:某些提供者(如 lm-studio)需要在 IP 前面加上http://。例如http://127.0.0.1:1234 本地提供者列表 | | |

|---|

| | 使用 ollama 作为 LLM 提供者,轻松本地运行 LLM | | | 使用 LM Studio 本地运行 LLM(将provider_name设置为lm-studio) | | | |

实战演习Run with an API设定config.ini。 [MAIN]

is_local = False

provider_name = openai

provider_model = gpt-4o

provider_server_address = 127.0.0.1:5000

警告:确保config.ini没有行尾空格。 如果使用基于本机的 openai-based api 则把is_local设定为True。 同时更改你的 IP 为 openai-based api 的 IP。 下一步:Start services and run AgenticSeek

Start services and Run(启动服务并运行) 如果需要,请激活你的 Python 环境。 source agentic_seek_env/bin/activate

启动所需的服务。这将启动docker-compose.yml中的所有服务,包括: searxng redis(由 redis 提供支持) 前端

sudo ./start_services.sh # MacOS

start ./start_services.cmd # Windows

选项 1: 使用 CLI 界面运行。 python3 cli.py

选项 2: 使用 Web 界面运行。 注意:目前我們建議您使用 CLI 界面。Web 界面仍在積極開發中。 启动后端服务。 python3 api.py

访问http://localhost:3000/,你应该会看到 Web 界面。 请注意,目前 Web 界面不支持消息流式传输。 |