|

OpenAI 开源了两款用于危害分类的开源权重推理安全模型:gpt-oss-safeguard-120b和 gpt-oss-safeguard-20b;这些模型接收开发者的策略文本和内容作为输入,返回分类标签和解释说明,让你可以用可审计的推理过程来执行自己的规则。 核心创新:这些模型将内容审核从固定分类器转变为基于策略的推理。修改规则就像编辑策略文本一样简单,无需重新训练、无需新数据集、无需新检查点。 因为策略是输入参数,你可以为不同产品、地区或年龄段切换不同策略,同一个模型就能遵循每一套规则。你还能获得解释说明,展示策略文本如何引导决策,这让审计和申诉变得更容易。 输出包含简短的推理依据,说明策略文本如何得出决策结论,大大简化了审查和申诉流程。 适用场景:这种方法在以下情况下表现出色: 风险是新出现的 训练数据稀缺 领域内容复杂微妙 需要高质量可解释的标签而非最低延迟

例如,论坛可以使用自己的定义来标记作弊言论,评论网站可以用自己的标准筛查虚假评价,只需编辑策略文本,无需收集数千个标注样本。 内部应用:在 OpenAI 内部,他们使用类似的工具叫Safety Reasoner,通过强化学习微调来奖励符合策略的判断,让模型学会从策略文本进行推理。 这种策略让他们能快速更新生产环境中的安全规则,先从严格开始,然后根据实际情况放松或收紧,这个过程称为迭代部署。 他们还报告称,安全推理有时确实需要大量算力,在某些发布中,谨慎应用策略消耗了总算力的16%。 实用架构模式:OpenAI 描述了他们内部技术栈的一个实用模式:先运行一个轻量廉价的分类器过滤明显安全的内容,只将少量棘手的项目发送给重量级推理模型。 Safety Reasoner 现已成为图像生成和 Sora 2 核心安全技术栈的一部分,逐步评估输出并实时拦截不安全的生成内容。 同样的分层检查机制在 GPT-5 和 ChatGPT Agent 等系统中根据详细分类法对输出进行分类,让平台能针对特定风险类别定制响应。

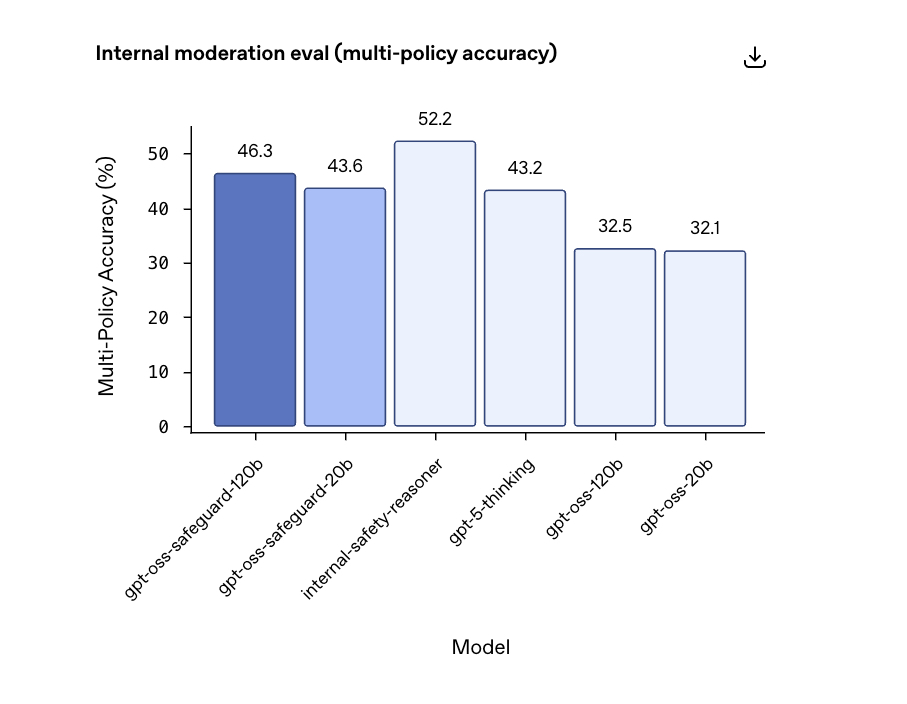

性能表现:多策略准确率测试(单个输入必须同时符合多个策略): gpt-oss-safeguard-120b: 46.3% gpt-oss-safeguard-20b: 43.6% 内部 Safety Reasoner: 52.2% gpt-5-thinking: 43.2%

这个指标很严格,只有模型在所有策略上都匹配黄金标签才算准确,是一个强调一致性的高标准。

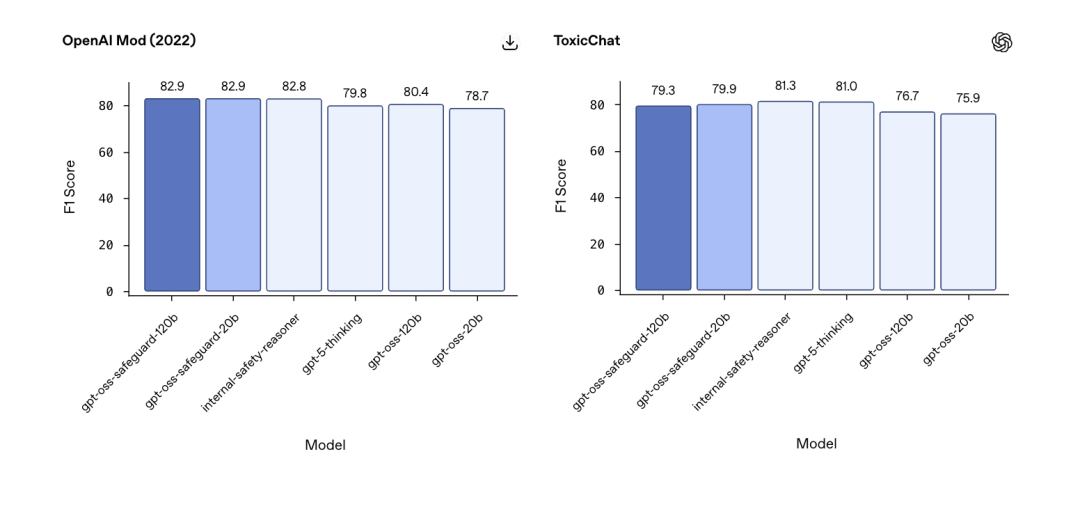

OpenAI 2022 审核数据集: ToxicChat 基准测试: 技术特点与局限:这些模型是 OpenAI 开源模型的微调版本,可以融入现有的开源权重技术栈,适用于有数据驻留或离线控制需求的场景。 明确的局限性: 使用建议:对于开发者来说,选择很直接: 核心价值:总的来说,这里最强大的理念是策略即提示词(policy-as-prompt)配合可见推理,它将安全规则与模型权重解耦,缩短了从策略变更到生产环境行为改变的周期。 如何使用 gpt-oss-safeguard:与gpt-oss 系列模型一样,这是一个开源模型,具有开放权重,你可以在本地运行或集成到自己的基础设施中。它设计为与harmony 响应格式配合使用。Harmony 是一种结构化提示词接口,为 gpt-oss-safeguard 提供完整推理栈的访问权限,并确保输出一致且格式规范。 运行环境:gpt-oss 系列模型(包括 gpt-oss-safeguard)可以在以下服务器环境中运行: vLLM(适用于专用 GPU,如 NVIDIA H100):gpt-ossvLLM Usage Guide;https://docs.vllm.ai/projects/recipes/en/latest/OpenAI/GPT-OSS.html HuggingFace Transformers(适用于消费级 GPU):How to run gpt-oss locally with LM Studio;https://cookbook.openai.com/articles/gpt-oss/run-locally-lmstudio Google Colab:How to run gpt-oss-20b on Google Colab;

https://cookbook.openai.com/articles/gpt-oss/run-colab 也可以在本地运行: https://cookbook.openai.com/articles/gpt-oss/run-locally-ollama 目标用户:gpt-oss-safeguard 专为需要大规模实时上下文和自动化的用户设计,包括: 机器学习/AI 工程师- 从事信任与安全系统工作,需要灵活的内容审核 信任与安全工程师- 构建或改进审核、信任与安全或平台完整性管道 技术项目经理- 监督内容安全计划 开发者- 构建需要基于上下文和策略的内容审核的项目/应用 策略制定者- 定义组织可接受内容标准,希望测试策略界限、生成示例并评估内容

模型地址:https://huggingface.co/collections/openai/gpt-oss-safeguard |