|

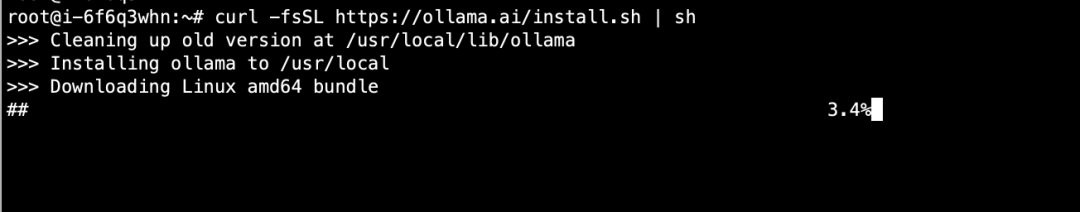

最近在研究大模型的落地应用,在本地使用2张GPU显卡部署了一套DeepSeek-r1模型,并搭配了Page Assist作为web ui。由于deepseek模型信息最新更新时间是到2023年12月,所有这个日期之后发生的事情,它是不知道的,而Page Assist有个联网搜索功能,可以很好的弥补这一点,之前一直不清楚他们是怎么配合的,今天重点研究了一下,也算是搞清楚了怎么回事。附上本地使用Ollama部署deepseek的步骤和设置。 1、本地安装Ollama ollama基础命令:

1)模型管理

ollama pull

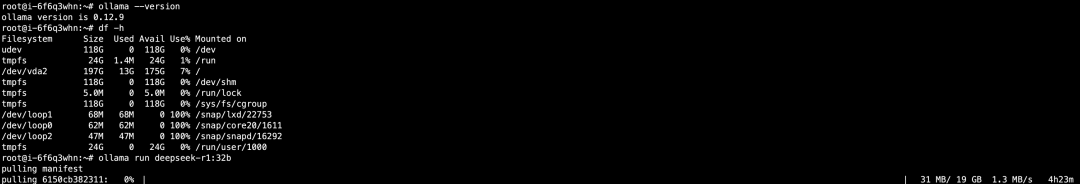

2、下载运行deepseek-r1:32b我这里使用的是32b的模型,大约20个G,进行本地研究应该是足够了,同时保证内存和磁盘空间足够。

ollama默认模型放置路径为/usr/share/ollama/.ollama/models

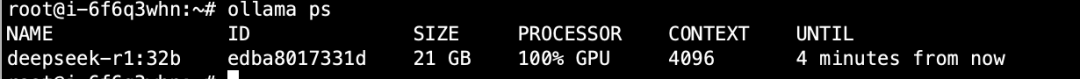

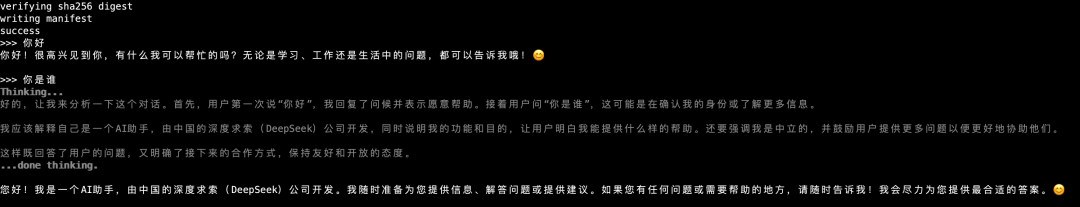

安装完成开始运行,使用命令ollama ps可以看到deepseek-r1:32b完全运行在GPU上。GPU使用的是2张A10 NVIDIA卡。提个问题试试。

回复测试没问题。回复/bye或者按Ctrl+D退出。

3、外部网络访问一开始直接启动,默认访问地址是127.0.0.1:11434,只允许本地访问。如果要放开外部访问,需要进行Ollama设置。 sudo vim /etc/systemd/system/ollama.service

在[Service]下面加上:

Environment="OLLAMA_HOST=0.0.0.0:11434" #运行所有地址访问

Environment="OLLAMA_ORIGINS=*"#运行跨域访问

sudo systemctl daemon-reload

sudo systemctl restart ollama

4、使用Chrome浏览器插件访问在本地浏览器上安装Page Assist作为web ui,访问插件地址https://chromewebstore.google.com/search/Page%20Assist?hl=zh-CN&utm_source=ext_sidebar  安装完成后打开  5、使用DeepSeek联网搜索当在没开启联网搜索时,询问当前日期是多少,它是无法回答的,只有开启才可以。  我本地deepseek模型是运行在服务器上的,且切断了互联网,它不可能直接联网查询。

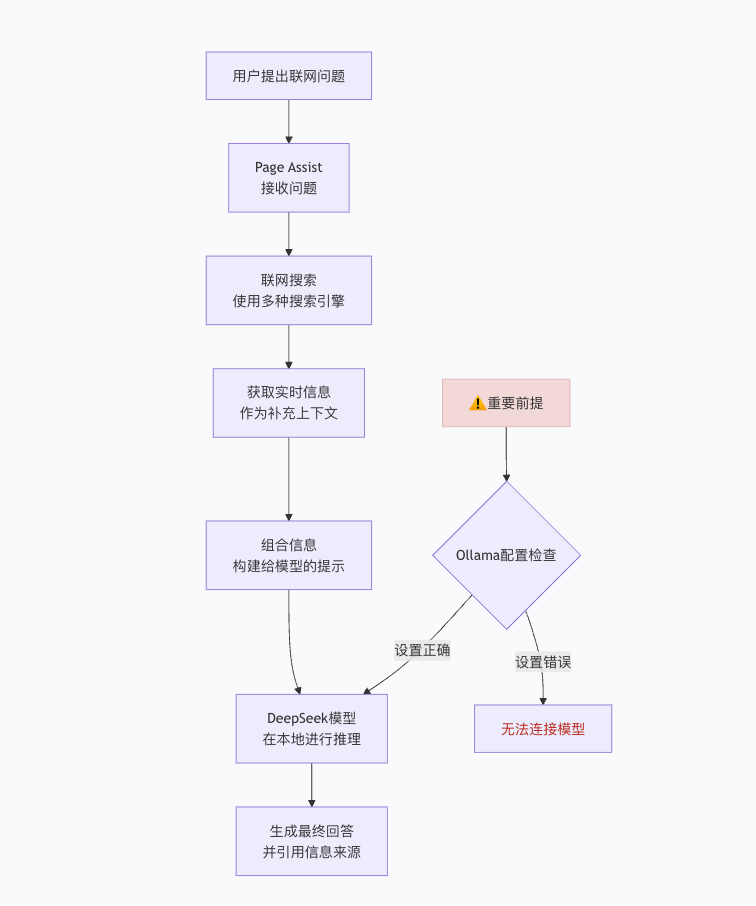

Page Assist作为浏览器扩展,它的联网功能是独立于DeepSeek模型运行的,当用户开启联网搜索时,Page Assist会通过预设置的浏览器直接访问互联网,用搜索引擎先进行实时查询,把获取的网络信息作为上下文,然后将这些信息与用户问题一起发送给本地的DeepSeek模型进行问题回答生成,最后再反馈给用户。大体流程如下图。  |