ingFang SC";font-weight: bold;color: rgb(255, 255, 255);line-height: 38px;visibility: visible;">

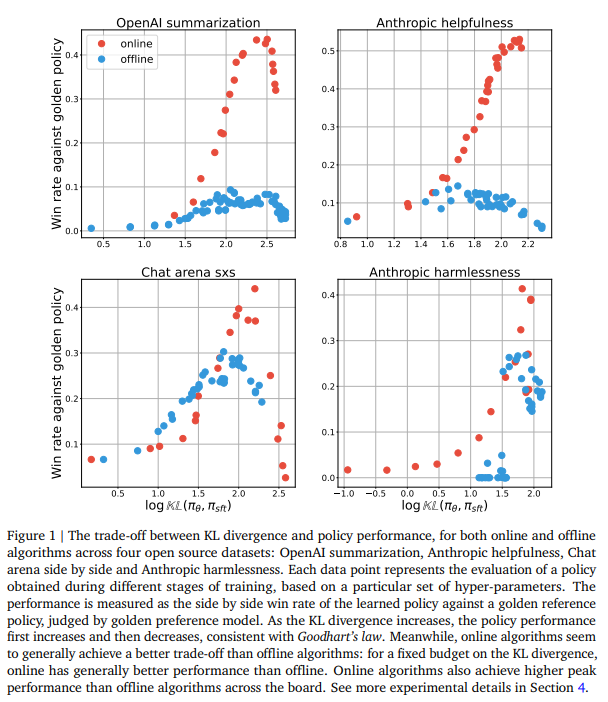

谷歌DeepMind的研究表明,尽管离线AI对齐方法具有效率和成本效益,但在线方法在对齐大型语言模型方面始终表现更优,这突出了策略采样在AI对齐中的重要性,并为进一步研究混合方法和改进离线学习策略提供了方向。 RLHF 是调整大型语言模型 (LLM) 的标准方法。然而,离线对齐方法的最新进展,例如直接偏好优化 (DPO) 及其变体,对 RLHF 中策略内采样的必要性提出了挑战。离线方法使用预先存在的 datasets 进行 LLM 对齐,无需主动在线交互,已显示出实用效率,并且实施起来更简单、更便宜。这就提出了一个问题:在线 RL 是否对 AI 对齐至关重要。由于在线和离线方法的计算需求不同,因此比较它们很复杂,需要仔细校准花费的预算,以便公平地衡量性能。 Google DeepMind 的研究人员在他们的初始实验中证明,在线方法优于离线方法,这促使人们进一步研究这种性能差距。通过受控实验,他们发现离线数据覆盖率和质量等因素必须完全解释这种差异。与在线方法不同,离线方法在成对分类方面表现出色,但在生成方面需要帮助。无论损失函数类型和模型缩放如何,差距都持续存在。这表明策略内采样对于 AI 对齐至关重要,突出了离线对齐的挑战。该研究使用与监督微调 (SFT) 策略的 KL 散度来比较各种算法和预算的性能,揭示了持续存在的差异。 该研究通过比较在线和离线 RLHF 算法,补充了先前关于 RLHF 的工作。研究人员发现了在线和离线方法之间持续存在的性能差距,即使使用不同的损失函数和扩展策略网络也是如此。虽然之前的研究指出了离线 RL 的挑战,但他们的发现强调了这些挑战扩展到了 RLHF。 该研究使用 IPO 损失比较了各种 datasets 上的在线和离线对齐方法,检验了它们在 Goodhart 定律下的性能。IPO 损失涉及优化获胜响应相对于失败响应的权重,采样过程的差异定义了在线和离线方法。在线算法对策略上的响应进行采样,而离线算法使用固定的 dataset。实验表明,在线算法在 KL 散度和性能之间实现了更好的权衡,更有效地利用了 KL 预算,并实现了更高的峰值性能。为了解释这些差异,提出了几个假设,例如数据覆盖率多样性和次优离线 datasets。 该假设认为,在线和离线算法之间的性能差异可部分归因于代理偏好模型与策略本身的分类精度。首先,当用作分类器时,代理偏好模型往往比策略实现更高的分类精度。其次,它提出这种分类精度的差异导致了观察到的在线和离线算法之间的性能差距。本质上,它表明更好的分类会导致更好的性能,但这个假设需要通过经验证据进一步检验和验证。

总之,该研究强调了策略内采样在有效调整 LLM 方面的关键作用,并揭示了与离线对齐方法相关的挑战。研究人员通过严格的实验和假设检验,揭穿了一些关于在线和离线算法之间性能差距的普遍看法。他们强调了策略内数据生成对于提高策略学习效率的重要性。然而,他们也认为,离线算法可以通过采用模仿在线学习过程的策略来改进。这为进一步探索开辟了道路,例如结合在线和离线方法优势的混合方法,以及对用于人类反馈的强化学习进行更深入的理论研究。 - 论文地址:https://arxiv.org/abs/2405.08448

|