|

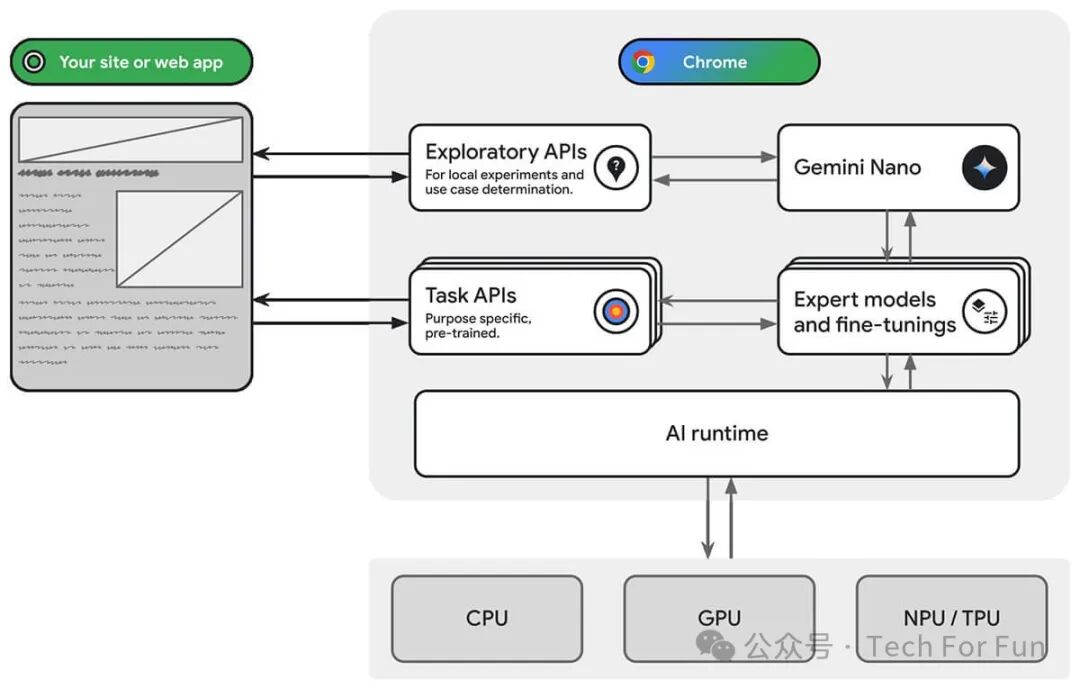

简介 从 Chrome 126 开始, Gemini Nano 将内置到 Chrome 中。为 Chrome 的数十亿用户提供引人入胜的设备端 AI 功能。这样就可以通过任务 API 和探索性网络平台 API 来访问 Chrome 中内置的模型:

使用 chrome 本地模型的好处: 本地处理敏感数据:设备端 AI 可以改进您的隐私保护故事。例如,如果您处理敏感数据,则可以通过端到端加密为用户提供 AI 功能。 流畅的用户体验:在某些情况下,无需往返于服务器,意味着您可以提供近乎即时的结果。设备端 AI 可能是可行功能与次优用户体验之间的区别。 对AI的访问权限更高:用户的设备可以承担一些处理负载,以换取对功能的更多访问权限。例如,如果您提供高级 AI 功能,则可以使用设备端 AI 来预览这些功能,以便潜在客户可以看到您产品的优势,而无需支付额外费用。这种混合方法还可以帮助您管理推断费用,尤其是针对常用用户流的推断费用。 - 离线使用AI:即使没有互联网连接,您的用户也可以使用 AI 功能。这意味着您的网站和 Web 应用可以离线使用或采用可变连接方式,按预期运行。

此外还可能提供探索性 API ,例如: 接下来让我看看如何安装和使用Chrome内置的Gemini Nano 。 安装 首先下载最新的Chrome Canary 版:https ://www.chromium.org/getting-involved/dev-channel/

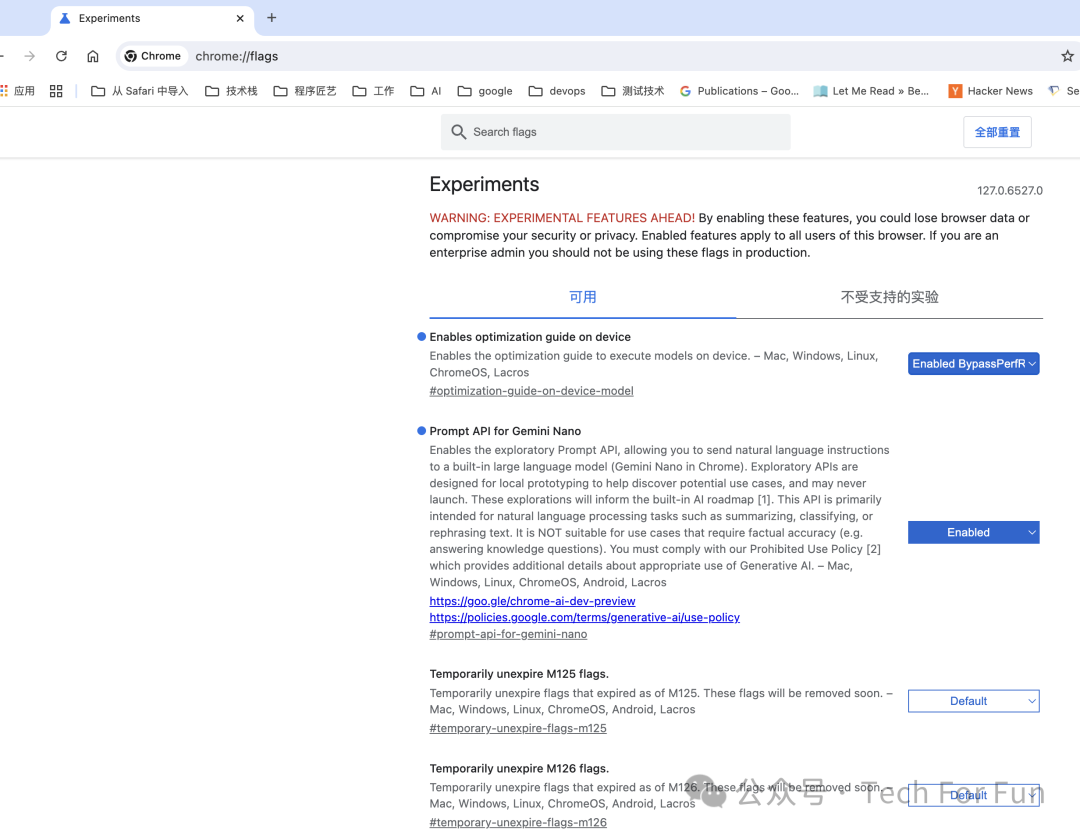

然后打开新安装的Chrome应用,按照以下步骤设置:

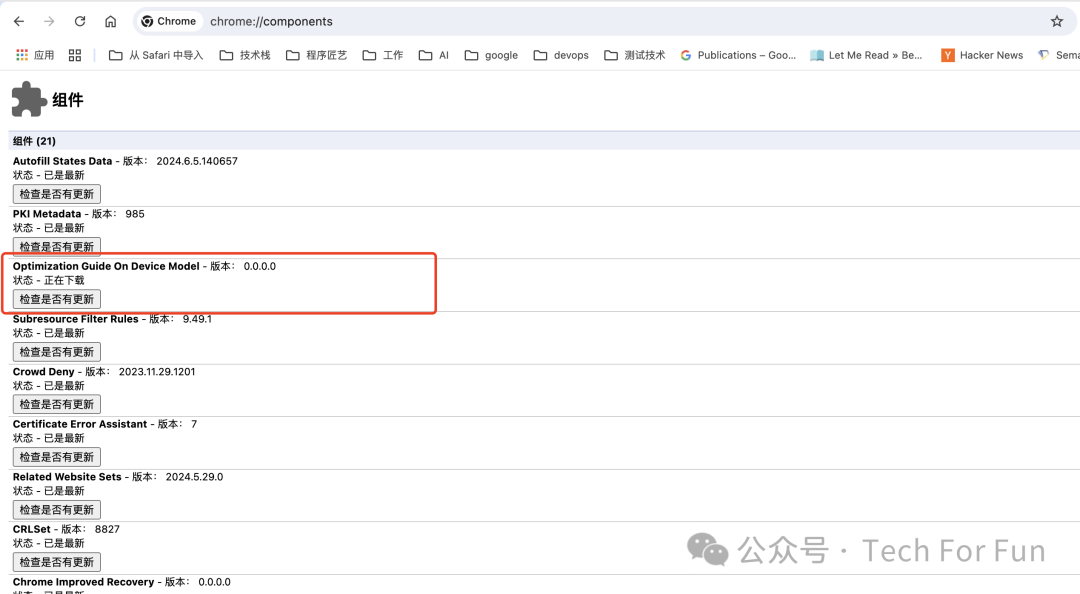

打开 chrome://flags/ 找到 Prompt API for Gemini Nano 设置为 Enable 找到 Enables optimization guide on device 设置为 Enable BypassPerfR 重启 Chrome 重启计算机 - 再次打开 Chrome并打开 chrome://components/

出现Optimization Guide On Device Model,则安装成功。

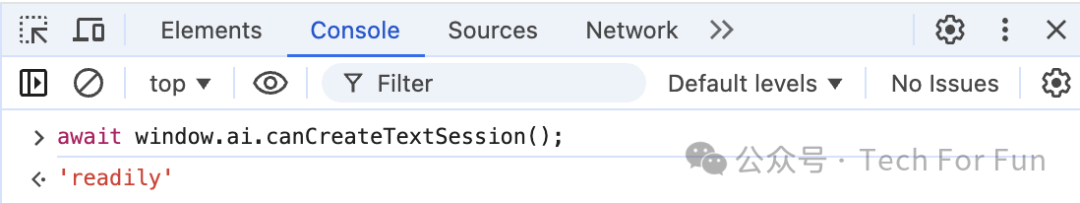

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.034em;">使用 打开 DevTools 并在控制台中输入以下代码: awaitwindow.ai.canCreateTextSession(); 如果返回readily,则模型是可用的:

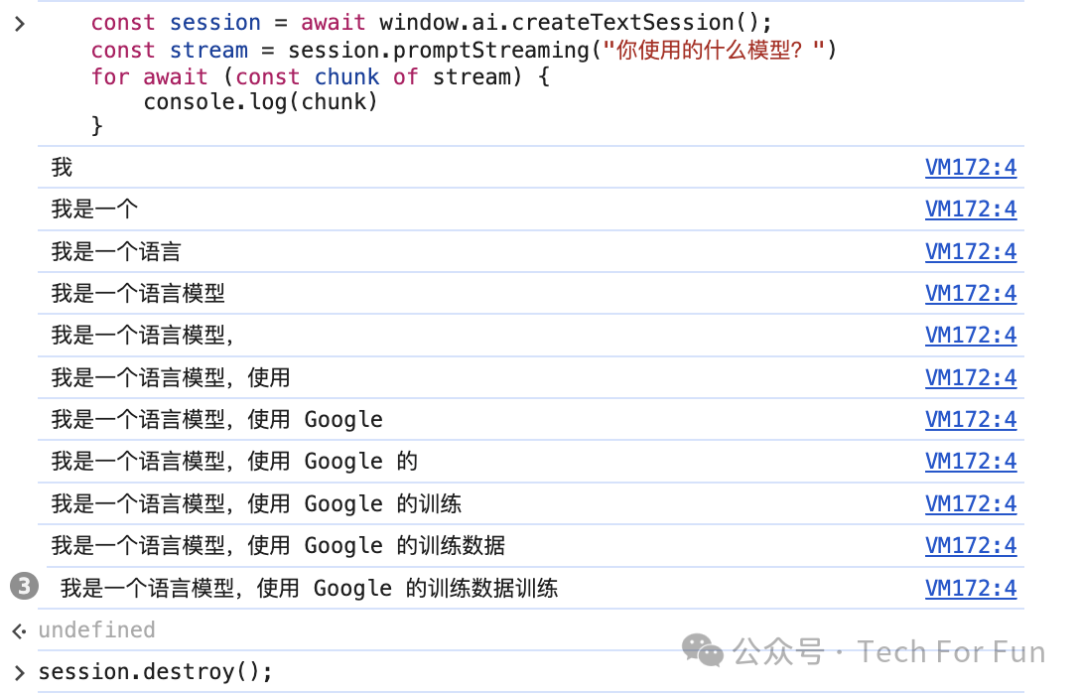

接下来可以使用Gemini Nano了,输入提示词试试:

constsession=awaitwindow.ai.createTextSession();conststream=session.promptStreaming("你使用的什么模型?")forawait(constchunkofstream){console.log(chunk)}

为了支持 Chrome 中的内置 AI,Google 还打造了获取在设备端执行的基础模型和专家模型的基础架构。此基础架构已在支持创新的浏览器功能(例如帮我写),并且很快就会支持用于设备端 AI 的 API,敬请期待~

|