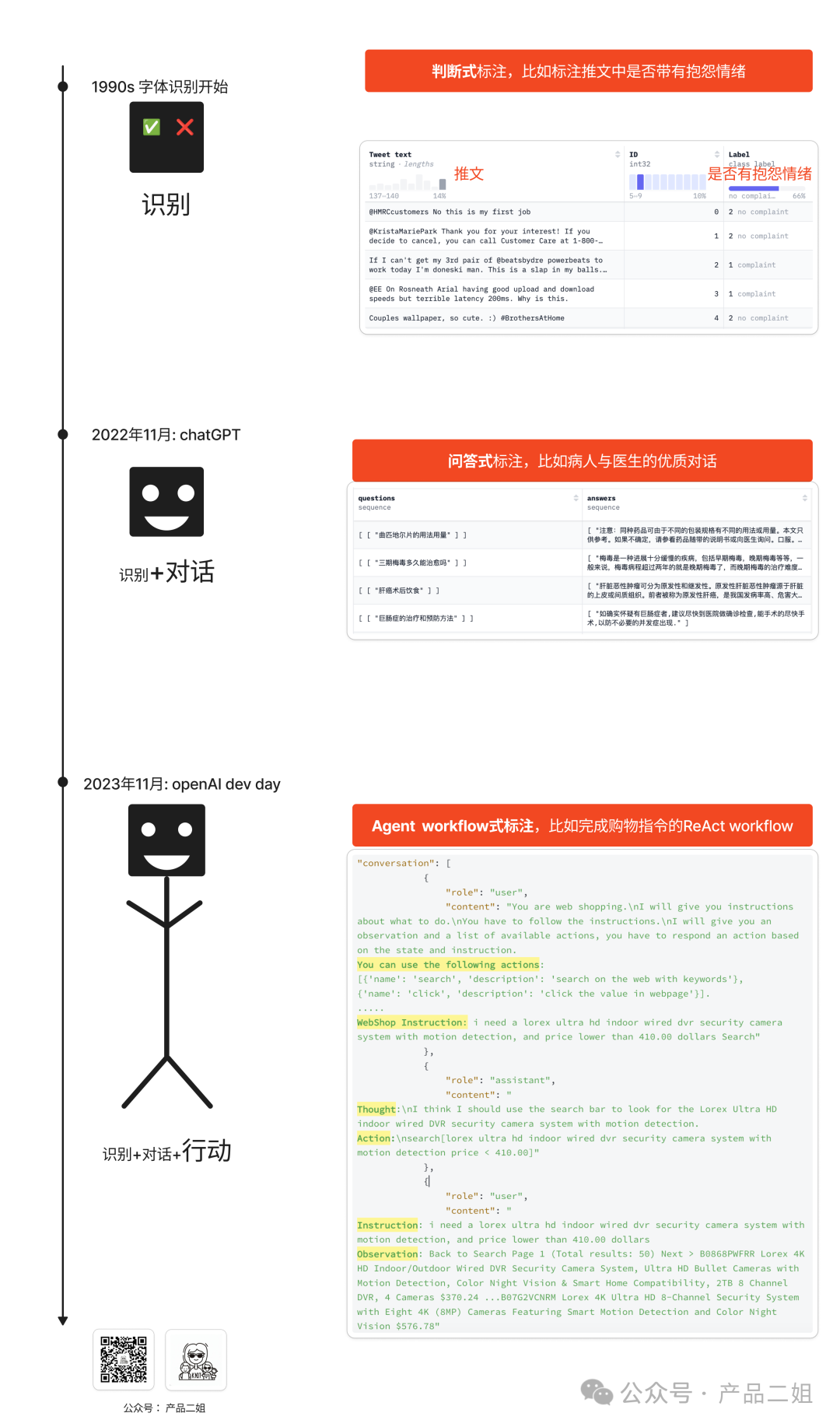

对于普通的AI应用开发者来说,改变模型参数的主要方式就是SFT(有监督微调)。在SFT中,训练数据总是成对出现:数据 & 标注。随着AI技术的发展,数据标注也产生了如下的变化:判断式标注→问答式标注→Agent workflow式标注。在下图中,我给出三种形式的例子(可放大图看例子更好理解)。

而这三种形式的数据逐步让神经网络拥有了识别能力→对话能力→工作执行能力;

也对应着三种产品形态:识别式产品 → ChatBot对话类产 → Agent思考+执行类产品。

其中Agent workflow式的数据集是专为Agent而生,用Agent workflow式的微调称为”Agent tuning”。如果说Agent是比Chatbot更具想象力空间,那么Agent tuning在不久的将来也可能会成为提高Agent能力的主流手段之一,之所以说可能,是因为目前Agent tuning主要在学术界活跃,还没有什么实际应用(已经整理好的Agent tuning相关论文、代码、数据集等资料,公众号回复“Agent微调”即可获得飞书链接)。

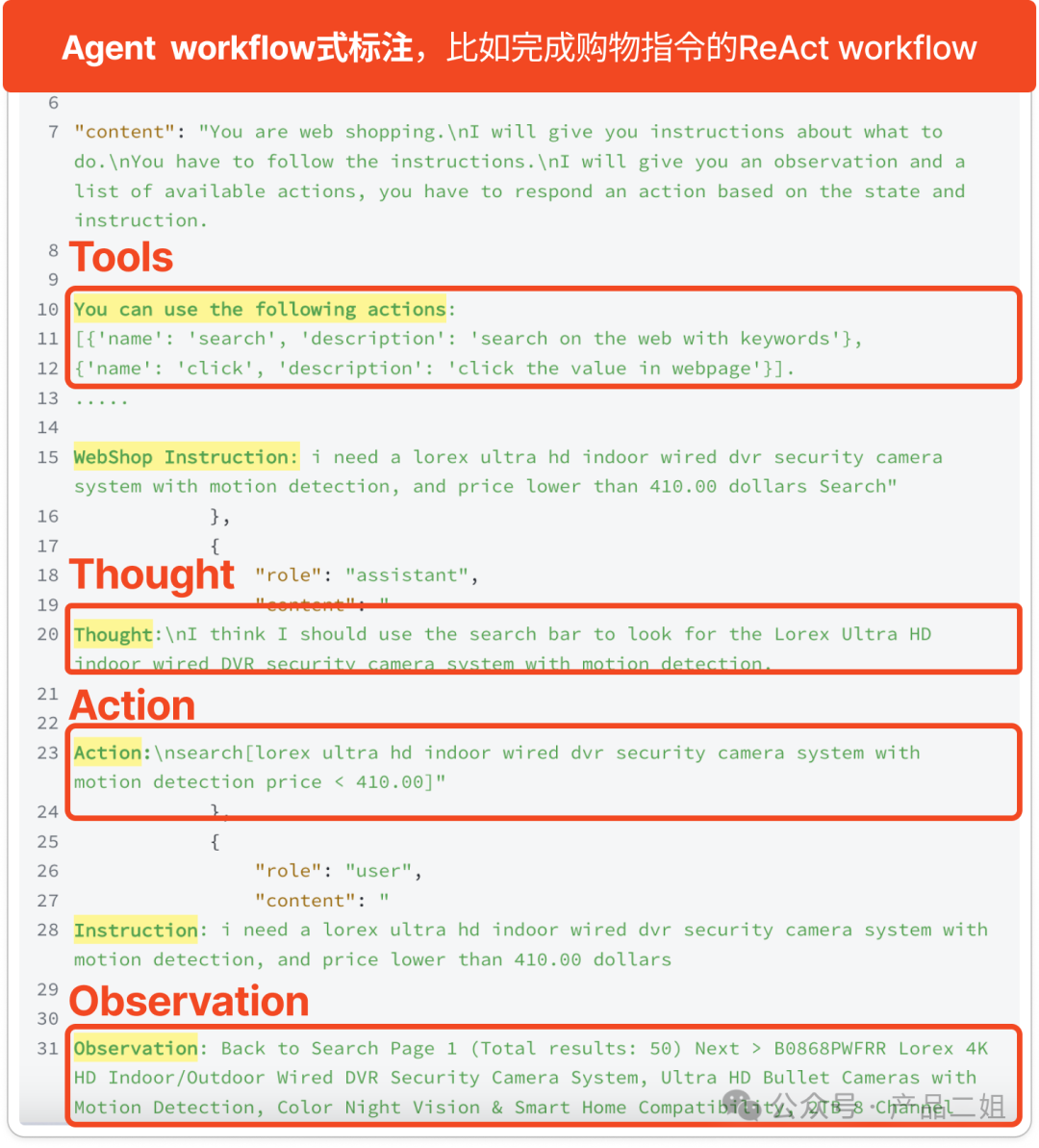

那么Agent tuning的数据长什么样呢,我们把上图的数据样例理解一下:User 与 Assistant 之间产生了多轮对话,最后一次回答就是这组数据的标签。而这种对话正是遵循着Re-Act模式展开(什么是Re-Act模式参考产品经理研读:Agent的九种设计模式)。

数据集来自:https://huggingface.co/datasets/THUDM/AgentInstruct/viewer/default/webshop

实际上Agent workflow式的数据集里,每一组训练数据就是提示词中的one shot。当你有1000个类似的样本时,就可以把它作为训练数据集来微调模型。

那么,Agent tuning的效果如何呢?在查阅了相关的论文和开源项目后发现:

1. 经过Agent tuning后的小模型在专业任务上的表现和原有小模型相比确实有大幅度提高。

2. 然而,这样的小模型效果仍然比不上最好的大模型(GPT4o)

在我们的实践中,Agent tuning的效果也是忽上忽下,这一进程仍然在艰难的探索之中,只能说目前没有定论:按照Software 2.0的理论是正确的,但这往往需要时间来实证,也可能我们还没有找到正确的方法。

如果你或者你所在的企业恰好也在探讨这一块,欢迎评论区留言一起来聊一下。

最后附上已经整理好的Agent tuning相关论文、代码、数据集等资料,公众号回复“Agent微调”即可获得飞书链接,希望能为你的前沿探讨省点力。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.578px;text-align: center;text-wrap: wrap;background-color: rgb(245, 247, 250);width: 500px;border-radius: 21px;"/>

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.578px;text-align: center;text-wrap: wrap;background-color: rgb(245, 247, 250);width: 500px;border-radius: 21px;"/>