|

先说一个暴论:AI 记忆正在成为最大商业机会,它是增量价值最明显、但体验最不稳定的一块。

2025 年,你买到的很多 AI 产品已经足够聪明了,可一旦你把它放进真实业务,它最容易在一个地方翻车:记忆。

这一点在海外Reddit社区上吐槽特别多。例如一个作者记录了 ChatGPT 在长对话里的记忆衰减,做了 11 天观察,核心抱怨是需要反复重建上下文,工作流被打断。

再比如,有人抱怨n8n 里的 AI Agent 记忆节点:工具调用结果没有被正确写入记忆,导致 Agent 表现不连贯。

而商业机会就在抱怨里:

Mordor Intelligence 预估作为独立基础设施的 Agent 编排与记忆系统 ,到 2030 年产值约 284.5 亿美元。

而作为记忆最强刚需场景的 AI Agents,到 2030 年约 503–526 亿美元。

再把想象力放大: IDC 预计企业 AI 解决方案投资 2025 年 3070 亿美元,2028 年 6320 亿美元。

记忆做不好,AI Agent就很难规模化吃到这块预算。

AI助手的死穴就在记忆

有个做 AI 硬件出海的朋友,他们的软件团队做了一个多模态的生活助理 Agent:帮用户管理日程和健康目标,识别用户习惯,结合设备端传感数据做长期建议,并实现跨手机 App、设备端语音、网页端统一体验。

他们已经做了两件很正确的事。

第一,知识库非常强。从产品说明、健康建议、品牌活动,到用户手册,RAG 做得很完整。

第二,他们用的是Gemini,上下文很能打,能到百万级 token 量级。

按理说应该够了。但他们遇到的卡点非常典型:同一个用户每周跑步计划有变化,饮食偏好有变化,设备提醒策略也要跟着调整。

可 Agent 的表现还是差点意思:知识库回答稳定,但个性化完全漂移。上下文再大,也只能保证当下这轮对话的连贯。跨端、跨周期、跨任务的连续性依然缺位。

聊下来,我们判断问题不在知识库,不在模型窗口,而在记忆系统。

上下文、知识库、记忆,它们在系统里的角色完全不同。

先聊清楚这3个让大家普遍迷惑的东西分别是什么:

上下文窗口是把最近的对话和信息塞给模型,让它在当前任务里保持连贯。窗口再大也有边界,而且天然是会话级的。它适合一次性写方案、短期问答、单次任务冲刺。

RAG 的核心价值是补齐模型权重之外的企业知识、业务数据、文档。它更偏静态知识和结构化事实。它适合企业客服知识问答、产品文档检索、合规和规则解释。

AI 记忆系统要保存并调用用户过去与模型的交互历史,为新会话设置上下文,并持续改进用户画像,让 Agent 能稳定输出个性化结果。

这类记忆通常会拆成更细的类型:

-

情景记忆(Episodic Memory):记录事件和对话轨迹。

-

语义记忆(Semantic Memory):从多次交互中提炼稳定事实。

-

用户画像记忆(Profile Memory):形成可复用的偏好和特征。

适合长期个性化助手、跨端连续体验、复杂工作流 Agent、需要稳定画像的运营和服务场景。

你现在应该能理解我为什么说我的朋友栽在记忆上:他们想要的是长期关系,而现成方案更多只能把这一轮聊顺。

2025 年主流产品都在补记忆,但痛点依然明显

ChatGPT

OpenAI 早在 2024就接入 ChatGPT Memory了。

核心逻辑是它的双通道结构:

- 一条是你显式要求或系统自动保留的 Saved memories;

- 另一条是引用过往对话的 Chat history。

老实说,对用户使用体验还是不错的,但也仅限C端。

这类记忆是平台内置能力,企业很难当成跨模型、跨应用的统一记忆层。对要做自研 Agent 的团队来说,依赖平台记忆等于把核心资产锁在别人系统里。

Gemini

Gemini 3 系列在 2025 年持续强化能力,它的两个优势对开发者非常有吸引力:一个是超(bao)大(li)上下文,一个是 Personal context 这类跨对话个性化设置。

但上下文强不等于长期记忆稳定。跨端体验、跨业务事件的统一画像,仍然需要独立记忆层去兜底。

用户吐槽

Claude Code

这类AI编程工具的思路很工程化:通过项目级的 CLAUDE.md 等文件,把偏好、规范、项目结构等以可控的形式带入每次会话,从而形成跨会话的稳定偏好与工作约束。 相比 Claude.ai 的记忆能力,Claude Code 更偏显式、人工驱动的记忆管理。

它的价值在于可控。但当你要处理多用户画像、复杂任务轨迹、跨系统数据沉淀时,仅靠配置文件显然不够。

MemMachine在尝试解决这些问题

回到开头说的场景,我给那位做 AI 硬件的朋友的建议结论很简单:把记忆从应用里拆出来。做成独立的 AI Memory 层。让它服务多个模型、多个端、多个 Agent。

找了几个AI记忆的解决方案,发现一个很强劲的产品:MemMachine

官网: https://memmachine.ai/

MemMachine 是 MemVerge 主导的开源 AI 记忆项目,于 2025 年 9 月正式开源。它不是依附于某个模型的附属能力,而是面向 Agent 与开发者的独立记忆层,这决定了它能成为架构中的长期组件。

看下来,它有四个核心优势:

第一是记忆类型的完整性。

除了常规的情景记忆和语义记忆,它还构建了 Procedural Memory 和 Profile Memory 的多层结构。其中 Profile Memory 是其核心差异点,其他方案涉及不多,但它能精准构建用户画像。在硬件场景中,这意味着系统能稳定记住用户的身份、风格与禁忌,而不是每次都重新认识。

第二是跨模型与部署的灵活性。

它支持 OpenAI、Claude、Gemini、Grok 等所有主流模型,并兼容公有云与私有化部署。这允许团队在云端使用强模型处理复杂推理,在边缘端使用轻模型处理即时响应,同时共享同一套用户记忆策略,满足企业对安全与跨模型的现实要求。

第三是标准化的接入方式。

它提供 MCP、RESTful API 与 Python SDK 等多种接口。这种设计非常适合被 n8n 等编排系统快速调用,降低了工程集成的复杂度。

第四是可验证的性能指标。

在评估长期对话记忆的 LoCoMo 基准测试中,MemMachine 取得了 92.34% 的准确率,处于行业领先水平。这让技术选型有了可复核的数据依据,而不必只靠主观感觉。

这些点为什么正中硬件朋友的痛?

他们需要的不是单次对话的聪明。而是把设备端的长期行为和对话端的长期偏好汇成一个可用的用户画像。还要能在未来换模型时持续复用。这类需求,用平台内置记忆很难做到。用只偏聊天摘要的简单记忆也不够。

而用 MemMachine 这种独立层才能形成真正的产品化护城河。

这套方案怎么落地到他的产品?

核心在于:要把记忆当作核心的产品资产来设计,而不是简单的日志存储。

第一步是定义 Profile Memory 的硬性框架。

我们需要明确哪些信息属于用户的核心设定。对于健康硬件来说,长期的健康目标、敏感的提醒偏好、交互时的语气风格,以及绝对的禁忌事项,都必须固化在这里。这确保了 Agent 无论在哪个端接入,都能维持统一的人设,不会出现性格漂移。

第二步是将关键交互转化为可复用的 Episodic Memory。

不要只记录流水账,要记录决策逻辑。一次训练计划的调整理由、一次异常心率后的用户反馈、一次用户明确否定的建议,这些包含上下文的片段才是高价值记忆。它们决定了 Agent 下一步的意图判断是否准确。

第三步是用 Semantic Memory 沉淀长期策略。

系统需要从零散的事件中提取规律。通过分析多次交互,总结出用户更接受怎样的提醒节奏,更相信哪种解释方式,以及在哪些时间段反复出现同类问题。这让记忆从单纯的记录变成了策略的稳定器。

第四步是设定可控的遗忘与更新规则。

一个商业化产品不能是个只进不出的容器。记忆必须设计成可解释、可清理的状态,过时的偏好要及时修正,冗余的信息要定期遗忘。

这样做的结果是,Agent 会随着真实使用而变得越来越稳定,做到跨端一致,并在下一次对话里少问几句废话。这才是硬件体验能真正拉开差距的地方。

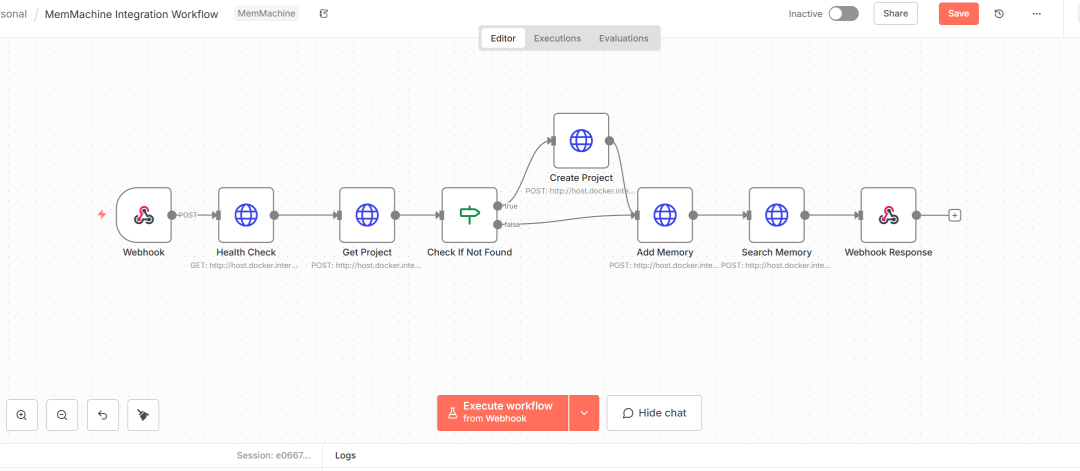

上手指南:用 n8n 快速接入 MemMachine

如果你刚好也在开发AI Agent产品,不妨简单接入试下。

项目地址:https://github.com/memmachine

对 n8n 用户来说,最顺的就是两条路。

路线 A

使用AI Agent的记忆Memory节点,或者使用 MCP Client 节点。把 MemMachine 当成外部记忆工具挂到 AI Agent 上,让 Agent 在需要时调用写入和检索。

路线 B

用 HTTP Request 节点直连 MemMachine 的接口 。在对话开始前先查 Profile 和最近 Episodic。在对话结束后把结构化结果写回三类记忆。

记忆应该成为AI产品的复利资产

回到开头提到的商业机会,核心不在于谁的模型更聪明,而在于谁的产品能随时间增值。

没有记忆的 Agent,第一天和第一百天的体验是一样的,它永远在重复消耗算力去解决同一个问题。拥有独立记忆层的 Agent,每一次交互都在为下一次降低成本、提升精准度。

在模型能力日益趋同的 2025 年,算法和算力都会变成标准品,唯独沉淀下来的用户记忆是无法被复制的壁垒。

把记忆当成基础设施去建设,你的 AI 产品才不是一个用完即走的工具,而是一个越用越懂你的复利资产。

你觉得呢?

|