https://github.com/idiap/ToPG

https://arxiv.org/pdf/2601.04859

A Navigational Approach for Comprehensive RAG via Traversal over Proposition Graphs

一、RAG 的三座“大山”

|

|

|

|

Chunk-RAG

|

|

|

|

Iterative-RAG

|

|

|

|

KG-RAG

|

|

|

一句话痛点:粒度 vs. 结构不可兼得——要么信息太粗,要么结构太硬。

二、ToPG 把“粒度”和“结构”同时做软

2.1 核心思想

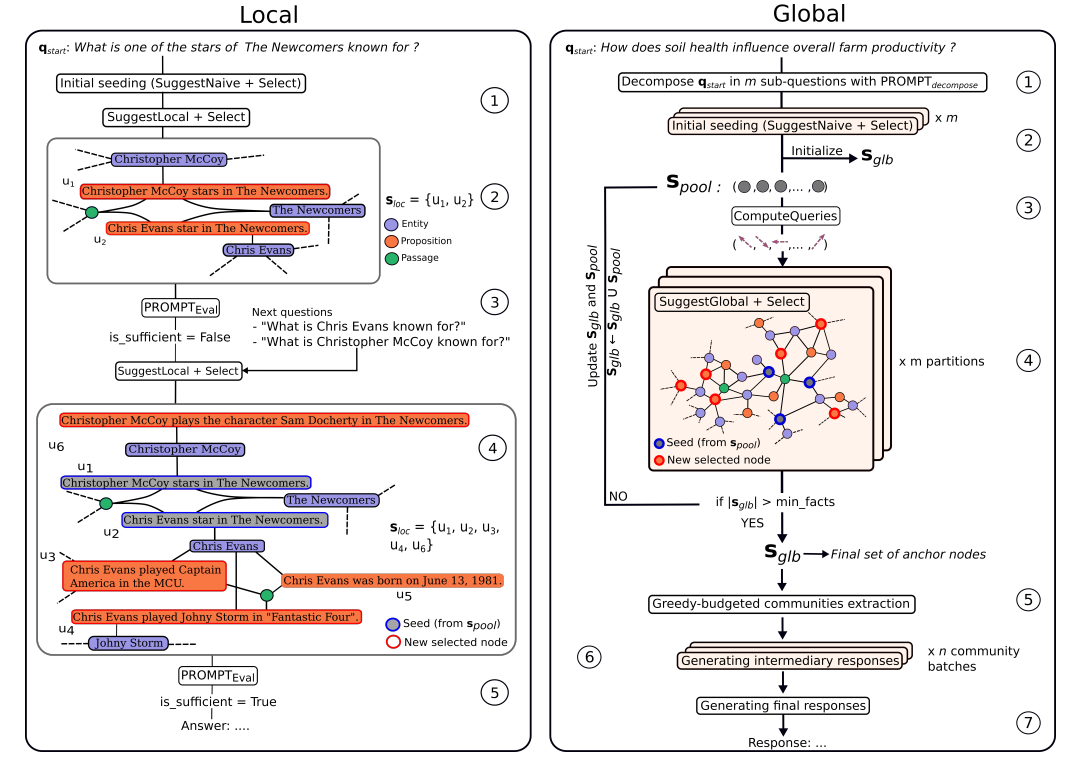

图 1 一张图看懂 ToPG 框架

异构图:命题节点(蓝色)既连实体(橙色)也连段落(绿色),实现“细粒度+高连通”

用命题(proposition)作为最小知识单元,把“实体-命题-段落”拼成一张异构图,再让 LLM 以“建议-选择(Suggestion-Selection)”的方式边导航边反馈,实现三种搜索模式:

|

|

|

| Naive |

|

|

| Local |

|

迭代 Suggestion-Selection,LLM 每轮筛掉噪音 |

| Global |

|

|

2.2 关键技术细节

图 2 分步骤示例:Local 模式如何 2 跳找到“Gloria in D 大调作曲家出生地的著名桥梁”

Global 模式:多起点并行游走 → 社区检测 → 综述答案

|

|

|

| 图谱构建 |

LLM few-shot 抽取实体→命题;同义词用 embedding 合并 |

|

| Query-Aware PPR |

转移矩阵 M = λ·结构 + (1-λ)·语义相似度 |

|

| Local 迭代 |

每轮 LLM 判断“信息够了吗?”不够就自动生成子问题继续走 |

|

| Global 社区 |

收集 600 个锚点 → Leiden 算法分社区 → 每社区生成中间答案 → 排序合并 |

|

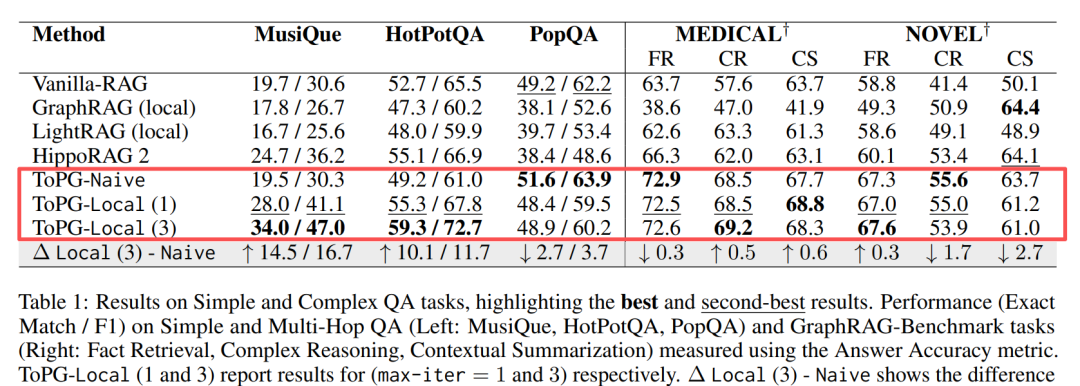

三、结论:一张表看懂涨点

单跳场景 Naive 模式已足够,Local 反而增加 token 成本;但在复杂场景,3 轮迭代即可把 F1 拉涨 11+

抽象问答(LLM-as-a-Judge)

图 3 胜率热力图:600 个锚点后收益饱和

|

|

|

|

| Comprehensiveness |

|

|

|

| Diversity & Empowerment |

显著优于

|

|

|

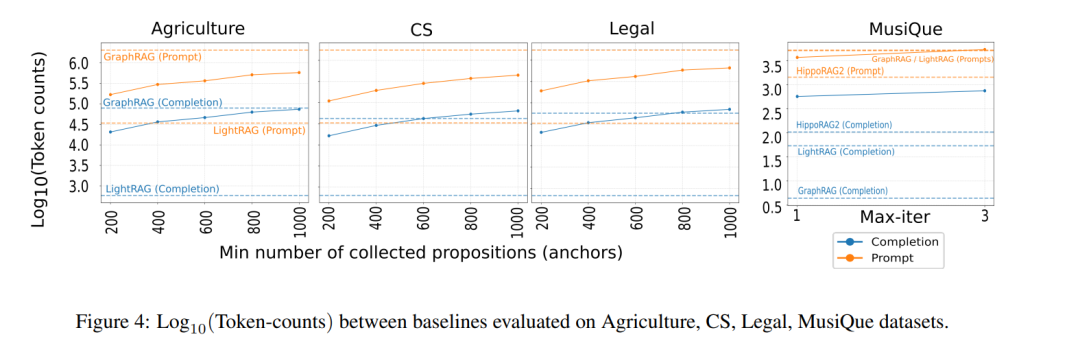

成本视角

图 4 Token 成本对比

|

|

|

|

|

|

| ToPG-Global |

|

比 GraphRAG 省 30%+ 生成 token |

|

|

|

四、一句话总结

ToPG 用“命题级粒度+查询感知游走”证明:把图谱做软、把导航做活,就能在单跳、多跳、抽象问答三条赛道都拿到 SOTA 级成绩。

|